Portál AbcLinuxu, 13. ledna 2026 07:34

Po minulém speciálu o nové grafické kartě Nvidie se dnes vrátíme do starých dobrých kolejí. Vedle tří zajímavých grafik, kterým se prostě nelze vyhnout, nás čeká jedno neméně zajímavé jednočipové SSD od TDK a také povídání o stavu 28nm výroby.

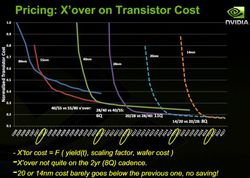

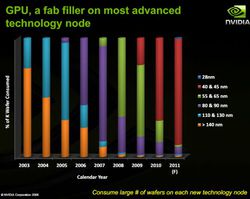

Faktorů pro současné vysoké ceny grafik, které by teoreticky mohly být levnější, je několik. Minule jsme si zmínili převážně ono marketingové hledisko, které se týká Nvidie, dnes je čas na vysvětlení z jiného soudku. Nvidia se na krátké prezentaci pokusila ukázat, jak v průběhu let rostly náklady na výrobu čipů jednotlivými výrobními procesy a pokud můžeme její prezentaci věřit, situace není úplně růžová a s ohledem na současný stav výrobních kapacit ve světě ani v budoucnu o moc růžovější nebude.

28nm výroba jako taková je výrazně dražší než dosavadní, již velice dobře odladěná 40nm, a z toho plyne skutečnost, že i přes výrazně menší velikost čipů jednoduše nelze dodávat partnerům čipy levnější. A to ani v tuto chvíli nehodnotíme výtěžnost výroby, však on by to ani nebyl dobrý ukazatel, když současné přibližně 4miliardové čipy by prostě nešly na 40nm výrobě rozumně vyrábět, nemluvě o schopnosti takových hypotetických čipů dosahovat při přijatelném TDP daných frekvencí nad 1,0GHz hranicí.

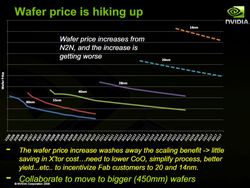

Z tohoto mimo jiné plyne, že je možné, že u některých čipů se oba výrobci (AMD a Nvidia) budou ještě nějakou dobu držet 40nm procesu i z toho důvodu, že na 28nm výrobu se stále ještě přechází a část výrobních kapacit stále tvoří čipy s většími tranzistory (nejen 40nm, ale i 55nm nebo i 90nm). Jistým řešením ryze z hlediska TSMC bude až zprovoznění dalších výrobních linek (to vyřeší problém s nedostatečnými výrobními kapacitami) a v dlouhodobějším horizontu i přechod od 300mm k 450mm křemíkovým waferům. Ale to je budoucnost trochu vzdálenější.

Nvidii i AMD aktuálně okolnosti nutí vyrábět jen u TSMC. Za prvé mají s touto firmou letitou a hlubokou spolupráci a nové GPU architektury jsou připravovány přímo pro továrny TSMC, přičemž přenositelnost kamkoli jinam (ať již k Samsungu, nebo v budoucnu i ke Globalfoundries a jiným výrobcům) není ani jednoduchý, ani levný proces. Zkrátka a dobře, momentálně jsme všichni obětí okolností vyplývajících z unikátního postavení TSMC jakožto světové špičky ve výrobě GPU a to se brzy nezmění.

Tolik k absolutnímu hledisku. Faktem jednoduše je, že vývoj menších a menších výrobních procesů je stále nákladnější a promítá se pochopitelně do ceny vyráběných waferů. Relativní hledisko nadále zůstává, to jsme si rozebrali minule: Nvidia vyrábí menší čipy než AMD, takže na nich velmi jistě daleko více profituje. Ale pokud ji nic nenutí zlevňovat, tak proč by to dělala, tomu snad rozumí každý. Jen doufejme, že se za nějakých 10 let nedozvíme, že zase spolu měli (jako před řadou let s ATI) nějaký ten cenový kartel. Bohužel schopnost regulačních orgánů je omezena jejich vlastní byrokracií a kostnatostí a to, že po několika letech, kdy firmy z cenových kartelů benefitují (ať již jde o ATI/Nvidia mezi GPU nebo o Samsung a další mezi RAM nebo třeba ryze česká specialita v podobě provozovatelů benzínových pump), dostanou X-miliardovou pokutu, nic nezmění na skutečnosti, že my jako zákazníci možná za produkty platíme více, než bychom měli v obecném slova smyslu.

V době, kdy japonská Toshiba (jejíž vědec na přelomu 70. a 80. let technologii NAND a NOR flash paměti vyvinul) slaví 25leté výročí od uvedení prvních flash pamětí, přichází TDK s nejnovějším počinem v oblasti SSD, počinem vpravdě sympatickým, který budeme jistě nalézat v hromadě malých přenosných zařízení. Pod označením TDK ERS3S1GBS se totiž ukrývá malinké 17×17mm pouzdro, které nese prostě vše: jak řadič a komunikační rozhraní, tak flashové části.

Nyní k tomu slovu &bduo;falešné“ v nadpisu. TDK sice celé SSD vpáchala do jednoho pouzdra, ale fyzicky jsou uvnitř ukryty dva čipy: jeden nese vlastní SSD a druhý zajišťuje komunikaci, tedy mimo jiné 3,0Gbps SATA rozhraní. TDK přitom použila kvalitnější SLC (single-level-cell) technologii, která v principu dává delší životnost než MLC a jiné, na druhou stranu se jí do malého pouzdra pochopitelně moc prostoru nevešlo: toto SSD míří na trh v rozmezí kapacit 1 až 4 GB. Nejde tedy o SSD pro nějaké budoucí iPady či mobily, tam stačí méně trvanlivá, avšak typicky kapacitně větší MLC technologie; TDK ERS3S1GBS je určeno primárně pro enterprise trh. Vedle rychlosti čtení/zápisu na hodnotě 55/30 MB/s firma slibuje 768 miliónů cyklů přepisu paměťových buněk.

Tak a když už máme na trhu oba zástupce 28nm hi-endu, je čas si ukázat zajímavá inženýrská cvičení. Tábor rudých zastupuje samozřejmě Sapphire, kterážto chystá na trh TOXICkou edici (ukázali jsme si ji již dříve, dnes si doplníme detaily) Radeonu HD 7970 s výrazně posíleným napájením, adekvátně dimenzovaným chladičem a rovnou 6 GB paměti. Cílem není efektivní karta, cílem je vyždímat z 28nm GPU AMD maximum.

Sapphire tak sáhl po vlastním PCB s vlastní napájecí kaskádou (8 + 3 fází) s kvalitními cívkami a speciálními napájecími tranzistory DirectFET od firmy International Rectifier. Karta je doslova osázena bloky chlazení, i zadní strana PCB je téměř kompletně zakrytovaná a celek chladí dvojice výkonných ventilátorů. Základní takt této karty také není referenčních 920 MHz/5,5 GHz, ale 1 150 MHz/6,0 GHz. Napájení je řešeno jako 8+8pin. Jedinou podstatnou chybějící informací je údaj o TDP případně výkonovém dimenzování napájecí části, ale to nakonec ukáží praktické testy. Pokud bych si měl tipnout, tak pokud klasický Radeon HD 7970 baští ve 3D typicky 210 W a maximálně 250 W, zde se budeme bavit minimálně 300W hranici, spíše ale více, protože tato karta si přímo říká o další přetaktování nad rámec samotným výrobcem zvýšených frekvencí.

Podobný počin, ale v opačném táboře zelených, chystá Zotac – firma, která soustředí své síly naopak ryze na GeForcky.

Jí poodhalená GeForce GTX 680 Extreme Edition neatakuje 2GHz frekvenci GPU, což v podobě kachny či informace ztracené v překladu kolovalo internetem, spokojí se s 1,2GHz taktem – i to je zhruba 20 % nad referenčním. Zotac přitom zvolil možnost vypnout technologii GPU Boost, takže karta sama od sebe nebude hnát frekvence výše, Zotac toto ponechává zcela v rukou uživatele.

Paměti jsou posazeny na výchozí frekvenci 6,0 GHz. I na Zotacu je vidět překopané PCB s vlastní napájací částí plus mohutné žebrování chladiče (kde bych se snad i trochu bál o přílišné nahuštění žeber).

Ač se sice neobávám o dostupnost TOXIC karty od Sapphire v Evropě, potažmo Česku, u Zotacu ta jistota prostě není a je klidně možné, že firma si tento model nechá jen pro některé neevropské trhy, případně do Evropy doputuje polooficiálními kanály jen pár samplů na testy. Každopádně v obou případech jde o pěkná inženýrská cvičení, osobně jsem nyní již jen zvědav, s čím přijdou lidé od Asusteku a také kdy představí duální GeForce GTX 680, jak mají již nějakou dobu ve zvyku.

na linuxe s uzavretymi ovladacmi pre grafiku je to lepsie no stale minimalne 1/2 slabsi vykon pri rovnakej spotrebe a rovnakej zatazi nez na windowse naprS ovladači NVIDIA rozhodně ne. Už jen proto, že kód mezi ovladači pro Windows a jiné OS sdílejí.

Ono je dost podstatné už to že DirectX pracuje s HW v hodně případech příměji (a tím i rychleji) než OpenGL, a to nemluvím o overheadu Xek, která komplexní grafický výkon Linuxu snižují značně.

Ono je dost podstatné už to že DirectX pracuje s HW v hodně případech příměji (a tím i rychleji) než OpenGL, a to nemluvím o overheadu Xek, která komplexní grafický výkon Linuxu snižují značně.

na linuxe skoro nehratelne obcasne sekanie , neplynule vykreslovanie fps kolo 40 az 50Vzhledem k tomu, že většina LCD monitorů se nepřekresluje rychleji než cca 50x za vteřinu a vzhledem k tomu že lidské oko vnímá jako plynulý pohyb cca od 20FPS, tak se mi zdá tvrzení "seká se" a "FPS okolo 40" v jedné větě tak nějak na hlavu.

niektory hard core hraci povazuju dostatocnu plynulost az pri 100FPSJojo, a pak se to vykresluje na LCD s "refresh rate" (ok, pro LCD je to tak trochu zavádějící údaj) 60Hz a zpožděním v několika desítkách milisekund :D

len tak pre porovnanie skuste si neaky program alebo najlepsie neaku 3D hru kde bude pod 60 FPS a prezerat si scenuZkoušel jsem s pár lidmi kteří tvrdí, že ten rozdíl poznají blind testy. Nepoznali :)

Jojo, a pak se to vykresluje na LCD s "refresh rate" (ok, pro LCD je to tak trochu zavádějící údaj) 60Hz a zpožděním v několika desítkách milisekund :DJenže to zpoždění je mazavé, což je lidskému oku milejší než ostré přeblikávání. Ale faktem je, že jet 100 FPS na 60 Hz je trochu k ničemu.

+1

U některých "700MB" filmů stačí i těch 20fps, ale u fullhd jde znatelně vidět trhání obrazu i při 24fps. Považoval jsem to napřed za nestíhající grafickou kartu / procesor, ale nový hardware to vyvrátil.

20fps pro akční hry je taky na výsměch - tam kolikrát ani 30-35fps nestačí, nemluvě o tom, že ve hrách musí být slušná rezerva pro náhlé snížení FPS např. v důsledku speciálního efektu.

Ono je dost podstatné už to že DirectX pracuje s HW v hodně případech příměji (a tím i rychleji) než OpenGLTak s tím bych si dovolil nesouhlasit. Rozdíl v „úrovni“ mezi OGL a DX není. Koneckonců funkcionalita i API jsou v současných verzích téměř identické (až na drobné na kosmetické rozdíly). OpenGL navíc hraje do karet i to, že ho vyvíji samotní tvůrci hardware, kdežto DirectX musí používat jakési „meziAPI“ pro komunikaci s ovladačem.

arachne : links v shell si niekedy skusal (bez neakych pridavkov ci pluginov) ? pretoze mne to prislo na dnesny web skoro nepouzitelne , nie len ze to zobrazovalo rozbite (alebo skor prapodivne upravene) stranky ale v tom pozerat neaku wiki stranku a hladat na nete ako vyriesit problem bol nieco otrasneMnoho lidí to v nouzi používalo, včetně mě. Textové UI se co do pohodlí obvykle GUI nevyrovná, ale vyhledávání informací na netu zase takový problém není. Někdy je to i o schopnostech uživatele, ne prostředí.

to je dnes uz uplne jinak :)Trochu jinak. Základní principy se zas až tak nezměnily.

V oblasti grafiky se změnily revolučně.Oblast grafiky a oblast vykreslování GUI nejsou ekvivalentní pojmy.

V podstate ano, nicmene zde soucasnym X-kum krivdite, nebot jiz maji slusne moznosti jak sahnout efektivne primo na graficky HW, pokud je to skutecne potreba.Pravdu díš, X-ka je možno obejít.

Co povazuji za vice neprijemne je velke mnozstvi hitorickeho balastu, ktery v podstate uz vubec nikdo nepouziva, ktery je vice nez obsolete, poplatny dobe vzniku a jehoz udrzovani zbytecne limituje a zneprehlednuje cely system.Možná je to na lepší cestě. V poslední době proběhly nějaké čistky v mese a Xkách, dokonce se mluvilo o odstranění xnest a xvfb (obě mají být nahrazeny speciálním ovladačem) a i o odstranění nějaké extension.

tak preco teda aplikacie (hry) pod linuxom maju nizsie FPS nez rovnake aplikacie pod windowsom na uplne rovnakom HW ?Hádal bych to na nějaké OS-specific optimalizace případně problém s ovladači pro konkrétní verzi HW. Tohle ale nedovedu dost dobře posoudit, protože Windows mám jen na laptopu s Intel MHD 4500, kde byl, když jsem to kdysi zkoušel, výkon v Lightsmarku v čerstvě nainstalovaných a aktualizovaných Win výrazně nižší než v Linuxu (Linux stabilně 25-30 FPS, windows čtvrtinu času kolem 5 FPS, v některých částech ale až 60, takže ve shrnutí byl výkon windows jen o trochu nižší). Kdysi dávno na nvidii 6200, když jsem ještě měl dualboot, byl rozdíl ve výkonu na úrovni statistické chyby.

tak preco teda aplikacie (hry) pod linuxom maju nizsie FPS nez rovnake aplikacie pod windowsom na uplne rovnakom HW ?Jaká hra, jaký HW, jaké ovladače?

Podstatné je, že DX přejímá vlastnosti a omezení HW na kterém běží, zatímco OGL vytváří abstraktní vrstvu, kde je možné jednotlivé (chybějící) vlastnosti HW emulovat. Pokud je aplikace navržená špatně, může to mít na výkon OGL dost negativní vliv.

Asi s tím už jsem otravný, ale i s tím si troufnu nesouhlasit. Do jisté míry by se dokonce dalo říct, že je to naopak.

Grafika, která chce podporovat Direct3D verze X (nejspíše) musí (technicky vzato by nemusela z důvodu popsaného dále, ale tuším, že je to jedna z podmínek MS, aby HW mohl mít nálepku „podporuje DirectX X“) implementovat veškerou potřebnou funkcionalitu v HW. Zároveň ale Microsoft poskytuje referenční softwarovou implementaci. Programátor dokonce může vynutit, že část pipeline poběží softwarově a zbytek poběží na dostupném HW (nebo SW, pokud HW danou verzi DX neimplementuje).

A jak je na tom OpenGL? Vzhledem k tomu, že ho tvoří samotní výrobci, AFAIK nikdo nevynucuje, aby HW podporoval veškerou funkcionalitu potřebnou pro danou verzi OpenGL. Teoreticky stačí, aby ovladač (libGL*) poskytoval rozhraní dané verze OGL i když není podporována přímo v HW. Realita je ale taková, že výrobci uvádějí jen tu verzi OpenGL, která je opravdu podporovaná přímo HW. Tohle se samozřejmě týká pouze core language, tj. funkcí začínajících na gl*, konstant a enumů začínajích na GL_* a části konstant a enumů začínajících na GL_ARB_*.

Kromě toho totiž OpenGL volitelně poskytuje výrobcům možnost rozšíření funkcionality pomocí tzv. extensions. Rozšíření je zatraceně hodně, protože prakticky každý výrobce má nějaká svá rozšíření. Např. GL_NV jsou rozšíření od nVidie, GL_ATI jsou od ATI/AMD atd. Z rozšíření jsou nejzajímavější GL_ARB rozšíření, což jsou rozšíření, která už se buď do core language dostala, nebo by se do něj měla dostat v některé z příštích verzí OGL, a GL_EXT, což jsou sice volitelná rozšíření, ale předpokládá se implementace více výrobci. Popravdě v rozšířeních je strašný bordel, protože kromě toho, že výrobci mohou implementovat svá rozšíření, přesouvají se rozšíření i mezi skupinami. Rozšíření, které tedy poůvodně začalo jako GL_NV může být v další verzi označeno jako GL_EXT, protože se ukázalo jako užitečné, a v další verzi může být přijato do core language jako GL_ARB. No, a kvůli tomuhle bordelu OGL poskytuje jakési rozhraní, které umožňuje zjistit, která rozšíření jsou v běžící implementaci OGL podporována a podle toho případně zapínat a vypínat funkcionalitu. Protože se to rozhraní ale nepoužívá úplně dobře, existuje hned několik projektů, které to balí do „hezčího balení.“ Takovým je např. GLEW.

On je na hovno všude krom počítačů používaných pro gamesení. Akorát se dobře napakuje ČEZ. ..."Blbost, GPU je výborná věc na výpočty.

ISSN 1214-1267, (c) 1999-2007 Stickfish s.r.o.