Ústavní soud na svých webových stránkách i v databázi NALUS (NÁLezy a USnesení Ústavního soudu) představil novou verzi chatbota využívajícího umělou inteligenci. Jeho posláním je usnadnit veřejnosti orientaci v rozsáhlé judikatuře Ústavního soudu a pomoci jí s vyhledáváním informací i na webových stránkách soudu, a to i v jiných jazycích. Jde o první nasazení umělé inteligence v rámci webových stránek a databází judikatury českých soudů.

Byla vydána nová verze 10.1 z Debianu vycházející linuxové distribuce DietPi pro (nejenom) jednodeskové počítače. Přehled novinek v poznámkách k vydání. Vypíchnuta je podpora NanoPi Zero2 a balíček WhoDB.

Konference Otvorený softvér vo vzdelávaní, výskume a v IT riešeniach OSSConf 2026 proběhne od 1. do 3. července 2026 na Žilinské univerzita v Žilině: "Cieľom našej konferencie je poskytnúť priestor pre informovanie o novinkách vo vývoji otvoreného softvéru a otvorených technológií, o možnostiach využitia týchto nástrojov vo vede a vzdelávaní a taktiež poskytnúť priestor pre neformálne priateľské stretnutie užívateľov a priaznivcov

… více »Korespondenční seminář z programování (KSP) pražského Matfyzu pořádá i letos jarní soustředění pro začátečníky. Zváni jsou všichni středoškoláci a starší základoškoláci, kteří se chtějí naučit programovat, lépe uvažovat o informatických úlohách a poznat nové podobně smýšlející kamarády. Úplným začátečníkům bude určen kurz základů programování a kurz základních algoritmických dovedností, pokročilejším nabídneme různorodé

… více »Fedora je od 10. února dostupná v Sýrii. Sýrie vypadla ze seznamu embargovaných zemí a Fedora Infrastructure Team mohl odblokovat syrské IP adresy.

Ministerstvo zahraničí Spojených států amerických vyvíjí online portál Freedom.gov, který umožní nejenom uživatelům v Evropě přístup k obsahu blokovanému jejich vládami. Portál bude patrně obsahovat VPN funkci maskující uživatelský provoz tak, aby se jevil jako pocházející z USA. Projekt měl být původně představen již na letošní Mnichovské bezpečnostní konferenci, ale jeho spuštění bylo odloženo.

Byla vydána pro lidi zdarma ke stažení kniha The Book of Remind věnovaná sofistikovanému kalendáři a připomínači Remind.

Grafický editor dokumentů LyX, založený na TeXu, byl vydán ve verzi 2.5.0. Oznámení připomíná 30. výročí vzniku projektu. Novinky zahrnují mj. vylepšení referencí nebo použití barev napříč aplikací, od rozhraní editoru po výstupní dokument.

F-Droid bannerem na svých stránkách a také v aplikacích F-Droid a F-Droid Basic upozorňuje na iniciativu Keep Android Open. Od září 2026 bude Android vyžadovat, aby všechny aplikace byly registrovány ověřenými vývojáři, aby mohly být nainstalovány na certifikovaných zařízeních Android. To ohrožuje alternativní obchody s aplikacemi jako F-Droid a možnost instalace aplikací mimo oficiální obchod (sideloading).

Svobodná historická realtimová strategie 0 A.D. (Wikipedie) byla vydána ve verzi 28 (0.28.0). Její kódový název je Boiorix. Představení novinek v poznámkách k vydání. Ke stažení také na Flathubu a Snapcraftu.

Sice mě rychlost momentálně nezajímá, ale proč to nezkusit, že(?)…

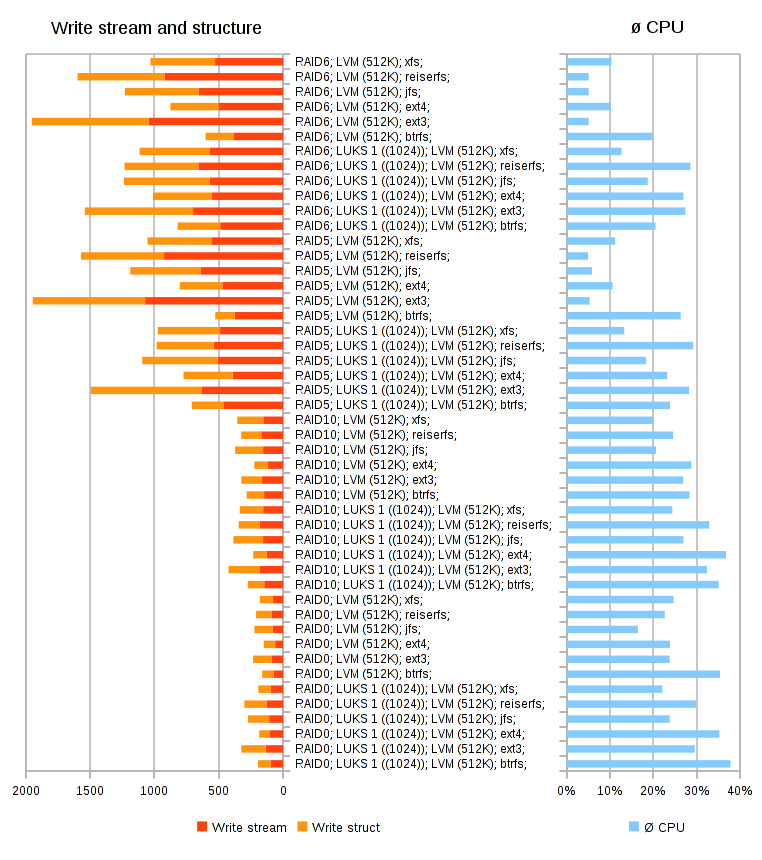

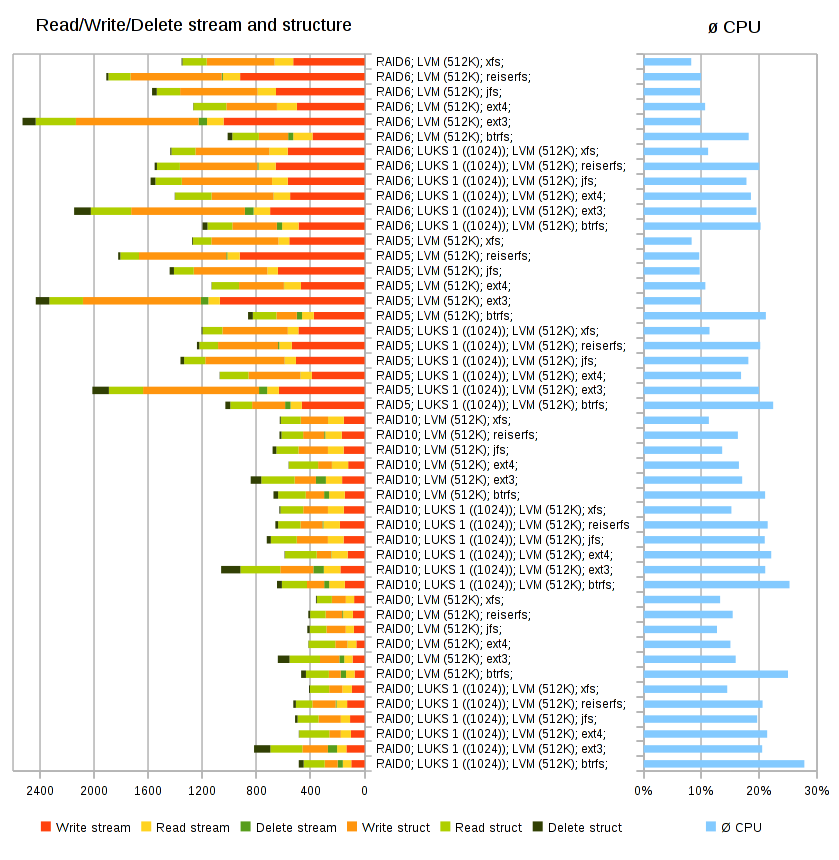

Do srovnání rychlostí kombinací úložiště jsem vložil i LUKS. Pro ty případy, kdy děláte například video či animace s porno záznamem své babičky, nebo třeba děláte nějaké výpočty pomocí MKP (FEM) kde vám to nějaký předpis nařizuje.

Otázkou je jestli by tyto kombinace dalších úrovní (RAID,LUKS,FS) generovaly stejné vzájemné pořadí, kdyby se jednalo o dva(tři, čtyři) SSD disky (nebo takové ty super SSD, co jsem ještě nikdy v ruce neměl, přímo do PCI-E).

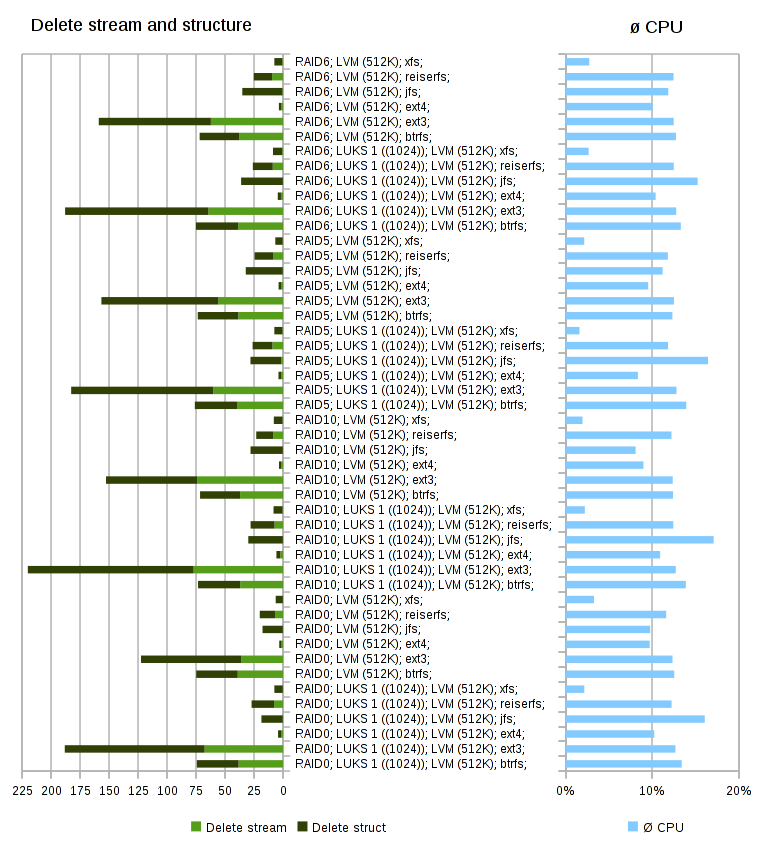

Surový zápis jsem trochu upravil (oflag=sync bs=268435456) celkem 32GiB v 32 souborech. Zapisují se předpřipravená (u)random data (1GiB v souboru v paměti na /dev/shm/). Provedl jsem i mazání pomocí find -type f -delete, pak je ještě smazána struktura již pomocí rm, v čase je zahrnutý i sync.

Struktura celkem obsahuje 223 adresářů a 22000 souborů celkem ≈25.5GiB v tříúrovňové struktuře.

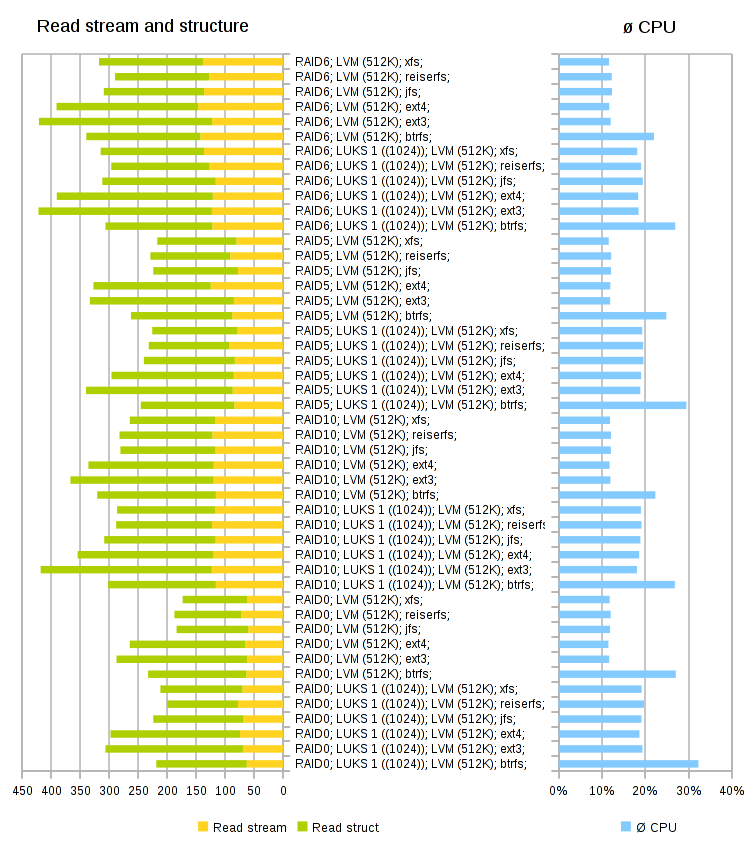

Čtení struktury je podobné jako mazání ted: find -type f -exec dd if={} of=/dev/null bs=268435456

Jako obvykle uvádím i ø vytížení CPU v % (v přílohách je to někde ×10), hodnoty jsou dobou trvání testu, tedy čím menší tím lepší.

V textu uvedu jen 4 grafy (jednotlivé nechávám v přílohách). Grafy jsem tentokráte neseřadil, minule byla námitka a možná je to tak i lepší.

Zde je odkaz na poslední graf setříděný dle času/rychlosti (rovněž je v příloze a v příloze je i dle CPU). Přece jenom na něco je to dobré…

Závěr:

Takovéto informace nejsou potřeba zas tak často, protože rychlost ustupuje jiným kritériím. Ale je spousta aplikací, kde o tu rychlost jde až v prví řadě a pokud máte na výběr z několika možností, tak se to může hodit, minimálně k tomu, aby se na základě toho provedl konkrétní aplikační test.

Pokud máme rychlé úložiště a jde nám o nenáročnost či rychlost, tak s btrfs si to musíme rozmyslet, přece jenom si z toho CPU docela dost ukrajuje, nevím jak by to dopadlo kdyby se použil btrfs RAID0…

Jinak xfs se zdá jako dobrá volba pro nenáročný a rychlý FS ve většině případů (ale ext4 není o mnoho náročnější). Každý si tam musí najít své…

Poznámka k brtrfs a jfs:

Jak jsem zmiňoval, v minulé „hrátce“, jedná se o CentOS 6.4 a jádro 2.6.32, tedy žádná novinka.

btrfs:

Všiml jsem si, že se za stejných okolností chová jinak, tedy přesněji podařilo se zapsat vždy trochu jiné množství dat.

Po skončeném zápisu s hlášením, že už tam neni více místa jsem dostal na df:

/dev/sdf1 22024192 19594732 377140 99% /root/testKdyž jsem chvilku počkal a zkusil dopsat:

dd if=/dev/zero /root/test/kukZapsalo se 717 kB a výpis přes

df vypadal takto:

/dev/sdf1 22024192 19972932 204 100% /root/testVíce už nešlo, ale obě čísla „free“ se u opakovaného stejného testu lišila, druhé nepatrně a první lítalo zhruba od 200000 do 390000.

btrfs jen vypsala:

ERROR: 'nějaká hláška vztahující se k příkazu' - Inappropriate ioctl for device…tak nevím, zkoušel jsem přijít na to kdy-jak-co, ale jediné co jsem zjistil, že se mi to stane jen někdy a to, když bezprostředně po vytvoření jej zaplním…

jfs:

Kombinace RAID5/6→LUKS→LVM→jfs (RAID6 i bez LUKS) po testu (zápis velkých dat, přečtení, smazání, zápis struktury, přečtení, smazání) na umount vykouzlilo doslova BSOD, černý terminál zmodral, umřelo to a restartovalo se to bez jakéhokoliv hlášení jak do terminálu, tak do logu.

Trochu jsem to analyzoval, ale pak jsem se na to vykašlal, je to moc na dlouho, došel sjem jen k tomu, že musí před tím na zařízení (RAID nebo LUKS) existovat FS btrfs a reiserfs, na který se něco zapíše smaže, a odmontuje se (asi jde o to, že se natáhne modul) nevím jestli oba nebo jen některý. Následně před vytvořením jfs se zapíše (nutná podmínka): dd if=/dev/zero of=zařízení bs=512 count=2048, pak se vytvoří jfs, něco se zapíše/smaže provede se vyprázdnění cache sync && echo 3 > /proc/sys/vm/drop_caches && sleep 1, promaže se to přes rm, provede se sync - opět nevím co všechno je nutné,... no a na umount „bác“.

Kombinace roztodivná, a těžko se přihodí, ale při testování to tak náhodou vyšlo a něco tam je zhnilého (může to být klidne „experiemtální“ modul btrfs, těžko říct).

Glosa na závěr: Je „fakt“, že zkušenost z dávné minulosti a z uživatelského hlediska, co šlo z IBM(AIX) bylo pocitově a výkonově horší, než co šlo s SGI(IRIX), a proto SGI(IRIX) skončil…

Tiskni

Sdílej:

![]()

![]()

![]()

![]()

![]()

![]()