V pátek 6. a sobotu 7. března proběhl v pražském sídle Nejvyššího kontrolního úřadu (NKÚ) Hackathon veřejné správy 7.1. Publikovány byly vytvořené aplikace. V kategorii projektů rozvíjených z krajského kola zvítězil tým „Mackokládi“. Čtyři středoškoláci ze Dvora Králové uspěli s aplikací KompaZ. Jde o digitálního průvodce, který pomůže s rychlou a srozumitelnou orientací v životních i krizových situacích „krok za krokem“. Aplikace

… více »QGIS, svobodný desktopový GIS, byl vydán v nové hlavní verzi 4.0. Změny zahrnují několik nových analytických a editačních funkcí, rozšíření podpory 3D, více možností úprav uživatelského rozhraní či mnoho dalších zlepšení použitelnosti. Řada 3.44 má aktualizace plánovány do září.

Dan Blanchard vydal knihovnu pro Python chardet v nové verzi 7.0.0. S novou verzí byla knihovna přelicencována z LGPL na MIT. Souhlasili s tím všichni přispěvatelé? Dan Blanchard souhlasy vůbec neřešil. Zaúkoloval umělou inteligenci (Claude), aby knihovnu zcela přepsala a výslovně jí nařídil, aby nepoužila žádný LGPL kód. Dan Blanchard tvrdí, že se jedná o clean room design. Protistrana argumentuje, že umělá inteligence byla trénována

… více »Andy Nguyen si na svou herní konzoli PlayStation 5 (PS5) pomocí exploitu Byepervisor nainstaloval Linux (Ubuntu). V Linuxu si spustil Steam a PS5 tak proměnil v Steam Machine. Na PS5 může hrát hry, které jsou vydané pouze pro PC a jsou na Steamu [Tom's Hardware].

Správce sbírky fotografií digiKam byl vydán ve verzi 9.0.0. Jedná se o větší vydání provázené aktualizacemi knihoven. Mnoho dílčích změn se vedle oprav chyb týká uživatelského rozhraní, mj. editace metadat.

Byla vydána verze 2026 distribuce programu pro počítačovou sazbu TeX s názvem TeX Live (Wikipedie). Přehled novinek v oficiální dokumentaci.

Jihokorejská Národní daňová služba (NTS) zabavila kryptoměnu Pre-retogeum (PRTG) v hodnotě 5,6 milionu dolarů. Pochlubila se v tiskové zprávě, do které vložila fotografii zabavených USB flash disků s kryptoměnovými peněženkami spolu se souvisejícími ručně napsanými mnemotechnickými obnovovacími frázemi. Krátce na to byla kryptoměna v hodnotě 4,8 milionu dolarů odcizena. O několik hodin ale vrácena, jelikož PRTG je extrémně nelikvidní, s denním objemem obchodování kolem 332 dolarů a zalistováním na jediné burze, MEXC [Bitcoin.com].

Komunita kolem Linuxu From Scratch (LFS) vydala nové verze knih s návody na instalaci vlastního linuxového systému ze zdrojových kódů Linux From Scratch 13.0 a Beyond Linux From Scratch 13.0. Pouze se systemd.

Byla vydána nová stabilní major verze 25.12 linuxové distribuce primárně určené pro routery a vestavěné systémy OpenWrt (Wikipedie). Jedná se o nástupce předchozí major verze 24.10. Přehled novinek v poznámkách k vydání. Podporováno je více než 2200 zařízení.

Na čem pracují vývojáři webového prohlížeče Ladybird (GitHub)? Byl publikován přehled vývoje za únor (YouTube). Odstraněn byl veškerý kód napsaný ve Swiftu. JavaScriptový engine LibJS byl reimplementován v Rustu.

get_all_articles.py vám stiahne z Wikipedie všetky názvy slovenských článkov.LANGUAGE = "sk"

a do main_categories stačí vložiť názvy kategórí z hlavnej stránky Wikipedie v danom jazyku.cat list/list.txt | wc -l 215128

sort list/list.txt | uniq -c | sort -nr | head

545 Imagine_Peace_Tower

189 Super_Jamato_(trieda_lodí)

189 Rimava_(rieka)

174 Slaná

165 Sovetskij_Sojuz_(trieda_lodí)

165 Scharnhorst_(trieda_lodí)

165 Jamato_(trieda_lodí)

165 Bismarck_(trieda_lodí)

163 Šinano_(lietadlová_loď)

157 Cirocha

Možno existuje nejaké elegantnejšie riešenie pre stiahnutie článkov z Wikipedie, ale neviem o ňom.

Takže som si extrahoval len unikátne názvy:

awk '!seen[$0]++' list/list1.txt > list/list-uniq.txtPočet jedinečných článkov je v skutočnosti 15723.

cat list/list-uniq.txt | wc -l 15723

download.py.

Všetky články sa sťahujú do priečinku articles. Ak sa z nejakého článku nepodarí extrahovať text,

tak sa zaloguje do errors/error_save_article.txt. (články sa u mńa práve sťahujú)echo Dom | ./majka -f w-lt.sk.fsa dom:k1gInSc1 dom:k1gInSc4 dom:k1gInSc5 dom:kATo nám to vypľuje, že je to Substantivum, rod mužsḱý neživotný, číslo jednotné v páde 1, 4 a 5. Do ľudského jazyka si to dekódujete pomocou tejto nápovedy.

Ale napríklad sa dá vyskúšať

miniature GPT

, LSTM, alebo čo vás napadne.

Najviac sa tešim, že by to mohlo celkom dobre fungovať, so slovnými druhmi + LSTM a nejaké hranie sa s tým.

Momentálne mám v pláne iné veci, ale chcel som si pripraviť aspoň nejaké dáta.

Ale napríklad sa dá vyskúšať

miniature GPT

, LSTM, alebo čo vás napadne.

Najviac sa tešim, že by to mohlo celkom dobre fungovať, so slovnými druhmi + LSTM a nejaké hranie sa s tým.

Momentálne mám v pláne iné veci, ale chcel som si pripraviť aspoň nejaké dáta.

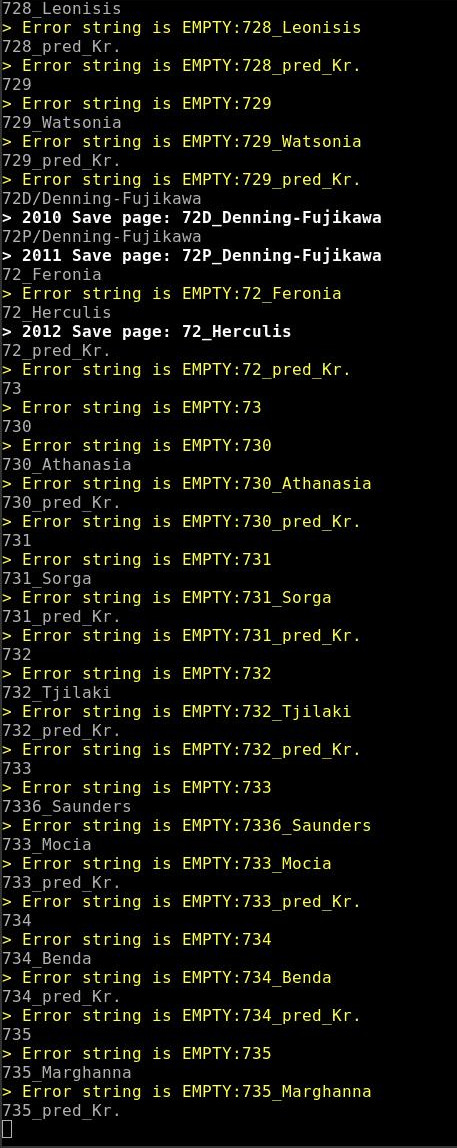

get_all_articles_special.py a stiahol 307149 názvov strániek. Na záver sa zacyklil , takže som skript musel vypnúť ručne. Nemajú to vyvhytané, pretože posledná stránka sa opakuje stále dookola. Teraz sa stánky sťahujú, mno kopec z nich sú obsahovo prázdne, ako je vidieť na obrázku nižšie.

Tiskni

Sdílej:

![]()

![]()

![]()

![]()

![]()

![]()

To je najlepšie.

Stiahneš: stiahneš

Výpis a spracovanie (nič extra ťažké): wiki.openzim.org/wiki/Zimlib

bliká to jako když vomylem máčknu banner s čínskou reklamou :O :O :D ;D

nóó tak vod nás angelinu pozdravuj :D ;D

Na záver sa zacyklil , takže som skript musel vypnúť ručne. Nemajú to vyvhytané, pretože posledná stránka sa opakuje stále dookola.Majú vychytané. Viď poslednú stránku toho zoznamu.

Teraz sa stánky sťahujú, mno kopec z nich sú obsahovo prázdne, ako je vidieť na obrázku nižšie.Ak dáš tie a la prázdne stránky editovať, tak zistíš, že nie sú prázdne. Máš označené, že prázdná stránka, ale tá stránka má a la užitočný text pre používateľa (myslený text vľavo v článku).

na nvidii nejlíp :D ;D

Mno jelikoz ses evidentne debil, kterej neumi stahnout databazi, a pripadne si ji nalejt do vlastni instance mediawikiNechcem si inštalovať softvér ktorý nebudem používať. Uvítal by som klasické zipko všetkých stránok. Niečo som dal teraz sťahovať, ale netuším čo v ňom bude (https://dumps.wikimedia.org/backup-index.html). Inak používam knižnicu, ktorá používa officiálne Wikipedia API, takže to robí trafic medzi 50 - 100kbit/s. To robím väčší DDOS, keď si pustím niečo na YT. 99% požiadaviek aj tak vybaví keš.

).

Nicmene, porizeni/sestaveni vhodnych vstupnich dat je asi nejslozitejsi cast vsech AI projektu. Takze je jasne, ze na tom nejaky cas stravis.

).

Nicmene, porizeni/sestaveni vhodnych vstupnich dat je asi nejslozitejsi cast vsech AI projektu. Takze je jasne, ze na tom nejaky cas stravis.