Jihokorejská Národní daňová služba (NTS) zabavila kryptoměnu Pre-retogeum (PRTG) v hodnotě 5,6 milionu dolarů. Pochlubila se v tiskové zprávě, do které vložila fotografii zabavených USB flash disků s kryptoměnovými peněženkami spolu se souvisejícími ručně napsanými mnemotechnickými obnovovacími frázemi. Krátce na to byla kryptoměna v hodnotě 4,8 milionu dolarů odcizena. O několik hodin ale vrácena, jelikož PRTG je extrémně nelikvidní, s denním objemem obchodování kolem 332 dolarů a zalistováním na jediné burze, MEXC [Bitcoin.com].

Komunita kolem Linuxu From Scratch (LFS) vydala nové verze knih s návody na instalaci vlastního linuxového systému ze zdrojových kódů Linux From Scratch 13.0 a Beyond Linux From Scratch 13.0. Pouze se systemd.

Byla vydána nová stabilní major verze 25.12 linuxové distribuce primárně určené pro routery a vestavěné systémy OpenWrt (Wikipedie). Jedná se o nástupce předchozí major verze 24.10. Přehled novinek v poznámkách k vydání. Podporováno je více než 2200 zařízení.

Na čem pracují vývojáři webového prohlížeče Ladybird (GitHub)? Byl publikován přehled vývoje za únor (YouTube). Odstraněn byl veškerý kód napsaný ve Swiftu. JavaScriptový engine LibJS byl reimplementován v Rustu.

Byla vydána verze 1.94.0 programovacího jazyka Rust (Wikipedie). Podrobnosti v poznámkách k vydání. Vyzkoušet Rust lze například na stránce Rust by Example. Zveřejněny byly výsledky průzkumu mezi vývojáři v programovacím jazyce Rust: 2025 State of Rust Survey Results.

Google zveřejnil seznam 185 organizací přijatých do letošního Google Summer of Code (GSoC). Dle plánu se zájemci přihlašují od 16. do 31. března. Vydělat si mohou od 750 do 6600 dolarů. V Česku a na Slovensku je to 900 dolarů za malý, 1800 dolarů za střední a 3600 dolarů za velký projekt. Další informace v často kladených otázkách (FAQ). K dispozici jsou také statistiky z minulých let.

Byla vydána únorová aktualizace aneb nová verze 1.110 editoru zdrojových kódů Visual Studio Code (Wikipedie). Přehled novinek i s náhledy a videi v poznámkách k vydání. Ve verzi 1.110 vyjde také VSCodium, tj. komunitní sestavení Visual Studia Code bez telemetrie a licenčních podmínek Microsoftu.

Apple představil 13palcový MacBook Neo s čipem A18 Pro. V základní konfiguraci za 16 990 Kč.

Kalifornský zákon AB 1043 platný od 1. ledna 2027 vyžaduje, aby operační systémy požadovaly po uživatelích věk nebo datum narození a skrze API poskytovaly aplikacím informaci, zda je uživatel mladší 13 let, má 13 až 16 let, má 16 až 18 let nebo má alespoň 18 let. Vývojáři linuxových distribucí řeší, co s tím (Ubuntu, Fedora, …).

Konference LinuxDays 2026 proběhne o víkendu 3. a 4. října v Praze v areálu ČVUT v Dejvicích na FIT. Čekají vás desítky přednášek, workshopy, stánky a setkání se spoustou chytrých lidí.

V současné době jsou firmy zahlcovány obrovským množstvím dat. Jejich zdrojem bývají firemní systémy (ERP, CRM, účetní a jiné vnitrofiremní systémy), externí dodavatelé (státní instituce, banky, výzkumné agentury), logy výrobních linek nebo také logy IT systémů.

Data obsahují nezměrné množství informací, které lidé potřebují transformovat ve znalosti a ty následně použít jako podklad pro svá rozhodnutí. A právě BI poskytuje nástroje, postupy a techniky vhodné pro extrakci informací z dat a nalezení relací mezi nimi.

Abychom toho byli schopni, potřebujeme systém, který by měl umět pokrýt následující oblasti:

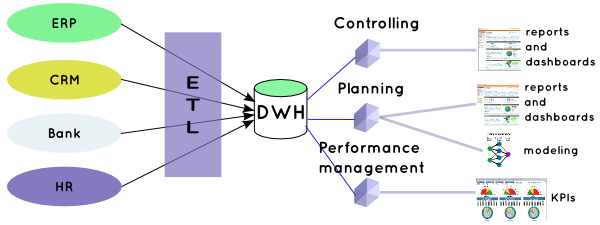

Schématicky to lze vyjádřit takto:

Firemní systémy mají většinou svá data uskladněna v databázích rozdílných architektur a struktur. Na obrázku jsou to vnitropodnikové systémy ERP, CRM, software na sledování docházky (HR) a jako externí systémy jsou zastoupeny výpisy z banky nebo měnové kurzy.

Naším cílem je data ze všech zdrojů centralizovat, zobecnit, ale zároveň zachovat potřebnou detailnost. Takto připravená data slouží pro analýzy, reporty nebo modelování faktů, která nám jsou známá. Ta, která zůstala doposud skryta, se snaží odhalit metody dataminingu.

Co to v praxi znamená?

Na databáze ERP, CRM a HR systémů jsou napojeny datové pumpy (ETL), které automaticky nebo na vyžádání „vytáhnou“ nová data a uloží je do datového skladu. V případě banky nelze předpokládat přímý přístup do bankovní databáze, takže jako zdroj dat budou složit offline datové soubory (XLS, TXT, …). Kurzovní lístek bude nejspíše dostupný na webu dané bankovní instituce, takže zdrojem je webová stránka. V tomto případě ETL musí zajistit převod nestrukturovaných dat do podoby vyhovující datovému skladu, takže musí provést určitou transformaci (například vyhledání hodnot kurzů v HTML).

Datový sklad musí mít takové rozhraní, aby z něj bylo možné stavět reporty nebo jej použít jako zdroj pro analýzy či modelování. Datový sklad obsahuje možné kombinace všech vstupních dat. Jelikož je rozsah informací příliš komplexní, je množina „nabízených“ dat omezena podle oborového zájmu na její podmnožiny. Těmi jsou datová tržiště, která bývají realizována datovými kostkami (ne výhradně).

Jednotlivá oddělení firmy pak přistupují pouze ke svým informacím, nad kterými si spouštějí reporty, procházejí dashboardy, analyzují data a vytvářejí si modely.

Cílem je přinést každému uživateli co možno nejkomplexnější informace, ale zároveň v co nejjednodušší formě a co nejrychleji.

Poptávka po BI v poslední době značně roste. Svoji roli hraje nejen neustále narůstající množství dat, ale také vzdělanost manažerů v oblasti využití moderních nástrojů pro řízení firmy. Podle hesla „Co nemůžete změřit, nemůžete řídit“ se ve firmách generuje množství reportů, stanovují se KPI, která by se také měla měřit a vyhodnocovat, provádějí se analýzy, sestavují modely. BI sice není všelék, ale při vhodném nasazení a zejména interpretaci dokáže nalézt a také pomoci řešit problémy firmy.

Firmy jako IBM, Microsoft, Oracle, SAP si toto uvědomují a většinou na vrchol svých databázových produktů stavějí BI řešení. Jelikož se jedná o komplikované systémy zahrnující i umělou inteligenci, jejich cena nebývá právě nejnižší. Z tohoto důvodu firmy často sahají po nestandardních řešeních, jakými je třeba nevhodné použití tabulkových procesorů. Nakonec ale s rostoucím množstvím dat a požadavků tato řešení čím dál více uživatelům ztěžují práci a více než analýzám problémů se věnují hledání chyb ve vzorcích a překopírovaných tabulkách.

Svět open source nabízí pro BI několik nástrojů (BI Jasper, Palo, Pentaho). V našem seriálu se budeme zabývat řešením od spolešnosti Pentaho – Pentaho BI. To patří mezi nejrozšířenější a nejkomplexnější open source nástroje pro BI. Zahrnuje několik samostatných aplikací (Mondrian, Kettle, Weka, jfreecharts, …), které jsou samy o sobě velmi kvalitní, a proto i často nasazované. Neodmyslitelnou součástí uceleného BI řešení je databázový systém jako zdroj dat.

Pentaho je komerční opensource nástroj, který je k dispozici v Community edition a Enterprise edition. Community edition je vydávána pod GNU GPLv2 licencí a je plně zdarma. Enterprise edition je placená a obsahuje některé komponenty, které nejsou vydávány pod GNU GPL2 nebo jinou svobodnou licencí. Srovnání obou verzí naleznete na http://www.pentaho.com/products/. Jako u většiny komerčních verzí open source je hlavní rozdíl mezi Comunity a Enterprise edition hlavně v podpoře ze strany Pentaho nebo jejich partnerů. Vedle toho Enterprice edition obsahuje i vylepšení, jako jsou Single-sing on, analyzátor výkonu systému nebo pokročilý grafický analyzátor OLAP kostek. Obě edice mají stejný základ, a to javovskou web aplikaci, běžící v aplikačním serveru (Tomcat, JBoss nebo třeba Glassfish). Některé moduly (designer kostek, reportů, ETL) jsou tvořeny samostatnými aplikacemi. Výsledek je publikován na server s Pentaho BI.

Pentaho ve spojení s dobře navrženým datovým skladem je velmi výkonný a spolehlivý nástroj na BI. S přehledem obstojí i v konkurenci proprietárních řešení. Díky možnosti integrace do jiných prostředí (intranet, vlastní aplikace) umožňuje pohodlně reportovat a analyzovat data, bez nutnosti složitých a krkolomých řešení. Pevně věřím, že vám bude tento seriál nápomocen.

První díl tohoto seriálu má úvodní, informativní charakter. Příště si rozběhneme komunitní verzi, ukážeme si její nastavení proti databázi PostgreSQL a provedeme si základní přizpůsobení.

Na shledanou s Pentaho

Nástroje: Tisk bez diskuse

Tiskni

Sdílej:

![]()

![]()

![]()

![]()

![]()

![]()

Dashboardy se pohodlne vytvareji javascriptem, na reporty, ETL, tvorbu kostek jsou klikatka, tak snad to nebude az tak moc krkolomne.

S diakritikou si poradime. FYI: Staci spoustit javu s parametrem -Dfile.encoding=utf-8 a jpivot umi zobrazovat i hacky, carky.

Dashboardy se pohodlne vytvareji javascriptem, na reporty, ETL, tvorbu kostek jsou klikatka, tak snad to nebude az tak moc krkolomne.

S diakritikou si poradime. FYI: Staci spoustit javu s parametrem -Dfile.encoding=utf-8 a jpivot umi zobrazovat i hacky, carky.

Tam ale nejspis budou mit trosku jine produkty

Tam ale nejspis budou mit trosku jine produkty

Spravne je samozrejme Extract, Transfer, Load. Kolega me na to taky upozornoval, ale nejak mi to uniklo. Musim to vic po sobe cist

Spravne je samozrejme Extract, Transfer, Load. Kolega me na to taky upozornoval, ale nejak mi to uniklo. Musim to vic po sobe cist

ETL = Extract, Transform, Load

ETL = Extract, Transform, Load