Zemřel Rob Grant, spolutvůrce kultovního sci-fi seriálu Červený trpaslík.

Apple oznámil, že iPhone a iPad jako první a jediná zařízení pro koncové uživatele splňují požadavky členských států NATO na zabezpečení informací. Díky tomu je možné je používat pro práci s utajovanými informacemi až do stupně „NATO Restricted“, a to bez nutnosti instalovat speciální software nebo měnit nastavení. Žádné jiné běžně dostupné mobilní zařízení tak vysokou úroveň státní certifikace dosud nezískalo.

Americký provozovatel streamovací platformy Netflix odmítl zvýšit nabídku na převzetí filmových studií a streamovací divize konglomerátu Warner Bros. Discovery (WBD). Netflix to ve čtvrtek oznámil v tiskové zprávě. Jeho krok po několikaměsíčním boji o převzetí otevírá dveře k akvizici WBD mediální skupině Paramount Skydance, a to zhruba za 111 miliard dolarů (2,28 bilionu Kč).

Americká společnosti Apple přesune část výroby svého malého stolního počítače Mac mini z Asie do Spojených států. Výroba v závodě v Houstonu by měla začít ještě v letošním roce, uvedla firma na svém webu. Apple také plánuje rozšířit svůj závod v Houstonu o nové školicí centrum pro pokročilou výrobu. V Houstonu by měly vzniknout tisíce nových pracovních míst.

Vědci Biotechnologické společnosti Cortical Labs vytvořili biopočítač nazvaný CL1, který využívá živé lidské mozkové buňky vypěstované z kmenových buněk na čipu. Po úspěchu se hrou PONG se ho nyní snaží naučit hrát DOOM. Neurony přijímají signály podle toho, co se ve hře děje, a jejich reakce jsou převáděny na akce jako pohyb nebo střelba. V tuto chvíli systém hraje velmi špatně, ale dokáže reagovat, trochu se učit a v reálném čase se hrou

… více »Pro testování byl vydán 4. snapshot Ubuntu 26.04 LTS (Resolute Raccoon).

Ben Sturmfels oznámil vydání MediaGoblinu 0.15.0. Přehled novinek v poznámkách k vydání. MediaGoblin (Wikipedie) je svobodná multimediální publikační platforma a decentralizovaná alternativa ke službám jako Flickr, YouTube, SoundCloud atd. Ukázka například na LibrePlanet.

TerminalPhone (png) je skript v Bashi pro push-to-talk hlasovou a textovou komunikaci přes Tor využívající .onion adresy.

Před dvěma lety zavedli operátoři ochranu proti podvrženým hovorům, kdy volající falšuje čísla anebo se vydává za někoho jiného. Nyní v roce 2026 blokují operátoři díky nasazeným technologiím v průměru 3 miliony pokusů o podvodný hovor měsíčně (tzn., že k propojení na zákazníka vůbec nedojde). Ochrana před tzv. spoofingem je pro zákazníky a zákaznice všech tří operátorů zdarma, ať už jde o mobilní čísla nebo pevné linky.

Společnost Meta (Facebook) předává React, React Native a související projekty jako JSX nadaci React Foundation patřící pod Linux Foundation. Zakládajícími členy React Foundation jsou Amazon, Callstack, Expo, Huawei, Meta, Microsoft, Software Mansion a Vercel.

HD sem, HD tam, HD všude kam se podívám.

Přibližně tak by se dalo shrnout šílenství, které jsem nucen poslední dobou kolem sebe pozorovat/poslouchat. Všichni vědí co chtějí. Kvalitu, ostrý obraz, detaily,… Což je také důvod proč si moji prarodiče pořídili HD(-Ready) LCD televizi i přesto, že ve svém věku jsou sotva schopni bez brýlí přečíst nadpis v novinách a mají do toho připojenou kabelovku ve které se síří signál PAL standardem (ovšem o HD jde bez pochyby, protože se mému dědovi podařilo najít na ovladači tlačítko s popisem HDMI). A také důvod proč mají někteří lidé na tomto portále nevědomou potřebu mě štvát (zatím je v LIFO frontě kyknos). Ale budiž. Na to už jsem si tak nějak časem zvykl. U čeho jsem se ovšem zase nedávno rozsekal byl tento článek a hlavně následná diskuse. Všichni jako degustátoři mají potřebu hodnotit kvalitu vína, i když by nepoznali ani rozdíl mezi dobrým vínem a výplachem z demižónu. Čímž samozřejmě nechci říct že já jo. Ale když už tu potřebu mají všichni, tak musím mít i já. I když ochuzenou o tu složku subjektivní, ať se nedopouštím stejné chyby. Ale pěkně od začátku.

A hned pro začátek připomeňme, že i když si značka HD může vztahovat k více parametrům, tak jde ve valné většině případů hlavně o rozlišení. Kdo chce vědět více, nech se podívá na historii. Co je to rozlišení by asi tak nějak intuitivně dovedl vysvětlit každý na tomto portále. Teda aspoň v to doufám. A na co má toto rozlišení vliv? Podle jistých pánů Nyquista, Shannona, Whittakera a Kotelnikova především na maximální šířku pásma, kterou je schopný takto navzorkovaný signál přenést. Jinak řečeno maximální frekvenci, kterou navzorkovaný signál obsahuje. Teda plus-mínus autobus. Těmi autobusy se zabývají některé vědy, především ta co se zajímá o zpracování signálů, takže opět kdo chce vědět víc…

A jak vysokou frekvenci je lidské oko schopno zaznamenat a lidský mozek zpracovat? No, asi hodně vysokou. Přesně to zřejmě nevíme doposud. Čísel jsem viděl několik. Jen tak v rychlosti jsem na internetu vygooglil pro jedno zdravé oko v místě s nejvyšší hustotou fotoreceptorů ekvivalent 576Mpix. Problém je jednak v tom, že oko nemáme jedno, ale dvě (signál z nich se skládá) a druhak to nejsou žádné stacionární fotoaparáty, ale spíše videokamery, které se mohou po scéně libovolně pohybovat, sbírat informace a v mozku detaily nadále časem zpřesňovat (Čistě pro zajímavosti viz třeba Beta movement nebo populární Lilac chaser). Ale zpět k našemu rozlišení. Tak jak se časem snímače zdokonalovaly a jejich rozlišení rostlo, objevil se nový, docela nepříjemný problém. Datová náročnost. Ta rostla v lepším případě exponenciálně. Takže už před docela dlouhou dobou se začalo s bádáním, jak tuto datovou náročnost alespoň trochu omezit. Celé snažení vyústilo v roce 1986 spoluprací a založením pracovní skupiny odborníků z řad standardizačních institucí ISO, IEC a ITU-T zvanou Joint Photographic Experts Group, zkráceně JPEG (podobná skupina byla v přibližně stejném čase založena i pro video a zvuk, kterou dnes známe pod názvem MPEG – mají toho mnoho společného a věřím, že nemusím blíže představovat). Jejich výsledkem bylo o pár let vydání různých standardů, doporučení a specifikací, které pokrývaly algoritmus pro snížení datové náročnosti statických obrázků vyházením určitých informací a následnou kompresí a také formátu, do kterého se to všechno balilo. Celý ten maglajz jsme si zvykli zjednodušeně nazývat formátem JPEG (i když upozorňuji – a dokonce mám pocit, že už poněkolikáté – že ve skutečnosti nic takového neexistuje).

Jde o takzvaný perceptuální ztrátový formát/algoritmus/kodek/cokoliv, který staví na dvou základních principech:

Pro následné testování budu používat rozlišení 1920x1080 a nebo nějakou obdobu. Jednoduše z toho důvodu, že je to nejvyšší rozlišení monitoru, který mám k dipozici. Každý může samozřejmě používat rozlišení jaké chce, jen bacha pokud se do rekonstrukce nebudete pouštět sami, ale budete si prohlížet výsledky tady aby obrázky byly škálované na správnou velikost.

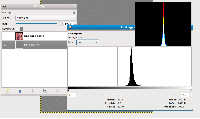

Takže si spustíme GIMP, založíme nový obrázek o rozlišení 1920x1080, pozadí obrázku vyplňme černou barvou, nad ním založíme novou průhlednou vrstvu a někam libovolně do plochy plácněme bíly čtverec o velikosti 1x1 pixel.

Tento čtverec nebo bod má dvě důležité vlastnosti:

Předpokládám, že s detekcí takového bodu by snad neměl mít nikdo problém. Jsme tedy schopni bod o této frekvenci detekovat a uvědomovat si ho. Až nebudeme, dosáhneme tak vysoké frekvence, kterou už lidský vizuální systém není schopen zpracovat. A teď zkusme do našeho obrázku importovat jako vrstvu nějaký jiný obrázek s komplexním prostředím a posuňme ho pod náš bod.

Předpokládám, že detekce takového bodu bude už docela problém, ne-li věc naprosto nemožná, i když vrstvu s pozadím budeme zneviditelňovat a zviditelňovat a tak znát jeho přesnou pozici. Pravděpodobnost detekce takového bodu závisí na několika věcech:

Jsme tedy schopni pozorovat jakousi obdobu maskovacího efektu z psychoakustiky, kde jeden jediný bod může být v naší hlavě maskován okolím které tento bod obklopuje. Samozřejmě jeden bod asi těžko něco zmůže, ale klidně můžeme zkoušet plácat bodů víc, měnit jejich hodnotu a zvětšovat je a zmenšovat je (je ovšem nutné dodržovat tvar podobný Gaussově křivce ať má takový bod alespoň trošičku zachovanou frekvenční charakteristiku), ale to nechť si laskavý čtenář všechno vyzkouší sám. Hlavně totiž můžeme dělat všelijaké pokusy s frekvencemi, do nichž se také hned pustíme.

Všechno výše uvedené jsou sice věci pěkné, ale jak takových věcí využít v náš prospěch? To musí na scénu vstoupit další z pilířů zpracování signálů: kvantizace. To už asi nebude tak jednoduché jako s rozlišením, ale bude stačit když si to zjednodušeně popíšeme tak, že je to počet bitů které jsou přiřazeny každému bodu. Čím víc bitů, tím přesněji můžeme určit skutečnou hodnotu vzorkovaného signálu v hodnotovém rozsahu a naopak čím méně dostupných bitů, tím více zaokrouhlování. A přesnost je to o co nám jde. 4-bity(16 barev), 8-bitů(256 barev), 16-bitů a 24-bitů a efekty volby různých bitových hloubek si snad ještě pamatuje každý, ne? Dále se tedy pokusíme o velmi zjednodušenou variantu Vlnkové transformace a pokusíme si ukázat vliv kvantizace v závislosti na frekvenci.

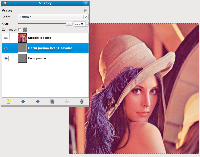

Opět si otevřeme GIMP a pro jednodušší práci do něj importujeme Lenu. Obrázek jednou zmenšíme, tedy na rozměr 512x512, pomocí Bikubické interpolace (není ideální, ale je po ní nejmíň bordelu) a opět pomocí Bikubické interpolace to co nám vyšlo přeškálujeme na původní rozměr, tedy 512x512. Dále jako vrstvu do obrázku importujeme podruhé původní Lenu, naši vyškálovanou variantu posuneme jako nejvyšší vrstvu, jednou tuto nejvyšší vrstvu zkopírujeme a zkopírovanou vrstvu zneviditelníme a na chvíli ji budeme ignorovat úplně.

Podle Nyquist–Shannonova teorému, o kterém už jsem se zmiňoval výše, by tato naše zmenšená varianta na poloviční rozlišení měla plus-mínus obsahovat také poloviční frekvenční rozsah. Ten nás ale moc nezajímá. Nás zajímá především ten druhý frekvenční rozsah, který ve zmenšené variantě nemáme. A jak se k němu dostat? Snadno. Pokud jeden obrázek obsahuje jednu polovinu frekvenčního rozsahu, druhý obrázek obsahuje celý frekvenční rozsah tak odečtením prvního od druhého by jsme měli dostat to co první obrázek neobsahuje: Druhou polovinu frekvenčního rozsahu. A tu potřebujeme. Odečtení provedeme snadno pomocí funkce/režimu Extrakce zrnitosti. Jde o obdobu zobrazení odlišnosti mezi dvěma obrázky(viz režim Odlišnost) s tím rozdílem, že s následnou odlišností se dá pracovat a zase se dá snadno takový výtvor sloučit a dostat tak původní obraz. Zvolíme tedy u vyšší vrstvy režim Extrakce zrnitosti a tuto vrstvu s tou spodní sloučíme. Měl by z toho vyskočit takový našedlý maglajz, který bude obsahovat nějaký šum a hrany původní Leny. Teď můžeme přestat ignorovat úplně nejvyšší zneviditelněnou vrstvu, vrstvu můžeme zviditelnit a nastavíme u ní režim Sloučení zrnitosti.

A čeho jsme to vlastně dosáhli? Dosáhli jsme toho, že horní vrstva obsahuje spodní polovinu pásma celého obrázku, druhá vrstva obsahuje horní polovinu pásma a že obě poloviny jsou sloučeny dohromady ve výsledný obrázek, který by se ani o pixel neměl lišit od původní Leny, kterou můžeme kdekoliv sehnat na internetu. Klidně si to můžete zkontrolovat. Jestli toto není paráda, tak už teda nevím co. Můžeme nyní spodní vrstvu zneviditelňovat/zviditelňovat a pozorovat jaký vliv má toto horní pásmo na výsledný obraz. I když neobsahuje mnoho informace, tak vliv na výslednou pociťovanou ostrost obrazu má docela zásadní. Za zmínku už snad jen stojí analýza horního pásma pomocí Histogramu u kterého můžeme pozorovat jak je většina informace soustředěna kolem hodnoty 127/128. Tato hodnota(tedy šedá barva) totiž znamená žádnou změnu oproti původnímu obrazu. Každá hodnota doprava či doleva znamená změnu od původního obrazu právě o tolik hodnot v pixelu o kolik je od této střední hodnoty vzdálena. Můžeme tedy pozorovat, že nejvíce pixelů není změněno vůbec, o něco méně ale pořád dost pixelů je změněno o jednu hodnotu, ještě o něco méně pixelů je změněno o dvě hodnoty, pár pixelů je změněno o pět hodnot, atd. Změn o více než pár hodnot je velice málo a velké deviace tak přibližně od hodnoty ±64 neobsahuje vůbec. Jednotlivé úrovně se dají dokonce zkoumat a pozorovat kde v obraze leží, ale o tom zas třeba někdy příště. Vraťme se už konečně ke slibované kvantizaci.

Přestože je možné provádět něco jako kvantizaci přímo v GIMPu, vyhnul bych se tomu a přenechal bych tuto práci ImageMagicku. Obsahuje velké množství vymakaných algoritmů, ale hlavně má téměř nekonečné možnosti nastavení. Exportujeme tedy horní pásmo do nějakého obrázku a následně zmenšíme počet barev na šestnáct, což by mělo odpovídat čtyřem bitům na pixel, pomocí příkazu:

$ convert high_band.tga -dither None -colors 16 high_band_quant.tga

Následně můžeme importovat kvantizovanou verzi přímo do GIMPu jako vrstvu a pustit se do zkoumání.

Dodal bych, že i když jsme volili 16 barev, ve skutečnosti se kvantizovalo pouze na 10. Jde totiž jen o jednoduchou metodu kvantizace, která má pár předdefinovaných úrovní na které hodnoty z celého rozsahu koncentruje a jak už víme, ty nejsou rovnoměrně rozloženy, ale nahňahňány u určité úrovně. Kdo chce více, musí si vytvořit vlastní mapování barev, využít nějakou sofistikovanější metodu ditheringu, atd. Znovu ponechávám na laskavém čtenáři.

Nevím jak kdo, ale já na první pohled mezi kvantizovanou verzí a originálem nepoznám rozdíl. A kolik jsme tím vlastně ušetřili? Originál je rastrový obrázek o velikosti 512x512 pixelů s hloubkou 24-bitů na pixel. 512*512*24=6291456 bitů. Se spodním pásmem nebudeme (krom pod-vzorkování samozřejmě) nic dalšího dělat. 256*256*24=1572864 bitů. Ovšem stejně jako jsme pod-vzorkovali spodní pásmo na rozměr 256x256 pixelů, měli bychom pod-vzorkovat i to horní, protože spodní část pásma není obsažena a je tak redundantní. My to bohužel provést nemůžeme, jelikož by bylo nutné použít ideální brick-wall filtry pro ořez pásma a ty jsme nepoužily, ale pro náš případ předpokládejme, že jsme tak učinili. V případě subsamplování bychom tedy získali tři obrázky o rozměrech 256x256 a s 4-bitovou barevnou hloubkou. Tedy 3*256*256*4=786432 bitů. Součet obou pásem by byl 1572864+786432=2359296 bitů. Umím-li dobře počítat, je to přesně 37.5% objemu z původních dat bez nějakého viditelnějšího zkreslení. Vysvětlení proč tomu tak je naleznete v prvním pokusu. Celé to píšu z toho důvodu aby bylo vidět proč čistě subjektivní srovnání není to pravé ořechové. No a také abych mohl říct, že přibližně nějak takto, jen mnohem sofistikovaněji pracuje JPEG a také MPEG. Nepracuje samozřejmě se dvěma pásmy, ale je schopen je dělit dále na mnohem menší a tak jim citlivěji přiřazovat prostor a preferovat jedny pásma před druhými.

JPEG pomocí kvantizačního součinitele interpoluje mezi hodnotami kvantizačních tabulek, které určují s jakou přesností bude zaznamenáno každé z šedesáti-čtyř pásem z bloku 8x8 pixelů. Žádané u něj je aby hodnoty, které určují nakolik se bude zaokrouhlovat byly tak vysoké, aby pro určité pásmo bylo vyčleněno 0-bitů. Jiným slovy aby bylo odstraněno úplně. Je ovšem nutné pamatovat na to, že ať už zvolíme kvantizační parametr jakýkoliv, kvantizaci podléhají téměř všechna pásma a tedy všechny frekvence ať už chceme nebo ne. Více viz velice povedený seriál Pavla Tišnovského o JPEGu. V závislosti na zvoleném kvantizačním koeficientu bude výsledek obsahovat různé data a bude mít různou velikost. Většinou výslednou velikost určujeme podle toho jakou šířku pásma dostaneme přidělenou pro určité médium(rychlost internetové linky, dostupný prostor CD nosiče,…). Tu nijak neovlivníme. Se zvětšujícím se rozlišením se zvyšuje také potřebná šířka pásma a proto musí do akce nastoupit kvantizace, která selektivně zmenší počet přidělovaných bitů a tím tedy i přesnost a velikost výsledku, tak aby se vlezl

. A konečně se pomalu prokousáváme k ultimátní otázce, kvůli které jsem založil celý zápisek: Co je víc? Větší rozlišení nebo nutnost menší komprese?

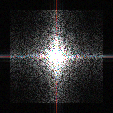

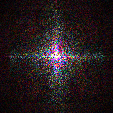

Pokud jste vše co jsem psal výše už věděli, klidně jste mohli celé to blábolení přeskočit až sem  . Při nedávném testováním mě velice zaujalo chování obrazu ve frekvenční doméně, které podléhalo kompresi JPEGem s různým QP koeficientem. Na první pohled se zdálo, že není moc vzdáleno od chování, které je možné pozorovat při škálování obrazu. A právě tehdy mě napadla ta otázka, co je teda vlastně víc? Logicky by se měl se zmenšujícím se rozlišením a adekvátně se zvyšujícím kvantizačním koeficientem pohybovat ořez frekvencí kolem jednoho místa. No neděje se tak. A jak to vlastně bude vnímat lidské oko? Nebudu napínat dlouho. Sepsal jsem si skript a provedl menší testík, kdy jsem originální obrázek docela rapidně zkomprimoval a následně zmenšoval rozlišení a zvětšoval koeficient tak aby velikost výsledku byla co největší, ale zároveň nepřesáhla velikost původního zkomprimovaného obrázku. Tedy aby výsledky o různých rozlišeních měly stejnou a nebo alespoň podobnou velikost.

. Při nedávném testováním mě velice zaujalo chování obrazu ve frekvenční doméně, které podléhalo kompresi JPEGem s různým QP koeficientem. Na první pohled se zdálo, že není moc vzdáleno od chování, které je možné pozorovat při škálování obrazu. A právě tehdy mě napadla ta otázka, co je teda vlastně víc? Logicky by se měl se zmenšujícím se rozlišením a adekvátně se zvyšujícím kvantizačním koeficientem pohybovat ořez frekvencí kolem jednoho místa. No neděje se tak. A jak to vlastně bude vnímat lidské oko? Nebudu napínat dlouho. Sepsal jsem si skript a provedl menší testík, kdy jsem originální obrázek docela rapidně zkomprimoval a následně zmenšoval rozlišení a zvětšoval koeficient tak aby velikost výsledku byla co největší, ale zároveň nepřesáhla velikost původního zkomprimovaného obrázku. Tedy aby výsledky o různých rozlišeních měly stejnou a nebo alespoň podobnou velikost.

První animace je v časové doméně a je vhodná k subjektivnímu testování. Druhá animace je totéž jen v doméně frekvenční, převedeno pomocí Fourierovy transformace. Na rozdíl od první animace jsem v tomto případě zvolil Brick-wall filtr čtvercového tvaru aby se lépe ořez sledoval (i když si teď tímto krokem nejsem moc jistý). Třetí animace je totéž co druhá, tedy ve frekvenční doméně, ale podložená obrazem originálu a se zobrazením rozdílů. Na ní je velmi dobře pozorovatelné jak kvantizace zasahuje nejen horní pásma, ale s narůstajícím rozlišením též ty spodní až po nulovou frekvenci(DC koeficient) včetně.

Ze všeho nejvíce mě ale překvapil výsledek matematického srovnání. Ten nijak nezohledňuje specifika lidského vizuálního systému. Je to čisté matematické srovnání. Grafem pouhého škálování je skoro přímka

v úhlu (±)45° v závislosti na použitém škálovacím filtru.

Žádný jednoznačný závěr dělat nechci. Jednak protože nikdo tady není žádná ovečka a každý si dovede dle svých vlastních zkušeností a znalostí (a pokud je nemá, tak doufám, že jsem je zápiskem pošoupnul aspoň o nějaký ten milimetřík) udělat určitě názor vlastní a druhak protože nejde o žádnou seriózní studii a klidně jsem se mohl splést. A věřím tomu, že jsem také někde chybu udělal. Ovšem můj čistě osobní názor, který z toho vyvozuji je takový, že pouhé hnaní se za obřími rozlišeními je holý nesmysl. A to se týká jak značky HD (a následovníků jako je 4k,Super Hi-Vision) u videa, tak obřích Megapixelů u digitálních fotoaparátů. Hlavně protože lidský vizuální systém není takové rozlišení schopný dostatečně ocenit. A argument pořiď si pořádné zobrazovadlo

pro mě není argumentem. Dále je nutné brát na vědomí, že s narůstajícím rozlišením krom datové náročnosti roste hlavně náročnost výpočetní. Snad i rychleji než exponenciálně. A té alespoň na současné technologické úrovni není na rozdávání. Pokud někomu není něco jasné a nebo má nějaké připomínky, nebojte se zeptat v následné diskusi. Budu se snažit…

Rula dne: Debris.

Tiskni

Sdílej:

![]()

![]()

![]()

![]()

![]()

![]()

Já to beru jako hlavní pozitivum HD blbostí, táhne to vývoj procesorů a datových médií.No právě, ale ti vývoj nestíhají. Pak se vymýšlejí takové blbosti jako HW offloading na grafické kartě pro pár vyvolených formátů.

DVD kvalitěSchválně. Jestli si všimneš, kolikrát jsem použil v zápisku slovo

kvalita. Neříkám, že jsem našel ekvivalentní náhradu, ale… Předpokládám, že myslíš rozlišení 720x576 a plně transparentní. A jestli stačí, nestačí. To je k polemizaci. Dle mého názoru bývala často bitrate tak vysoká, že to bylo zbytečně redundantní. Hlavní chybou je zaseknout se na nějakých levelech

kvality.

Co se mne týká, rozdíl mezi DVD a BD na HD Ready (1366x768) televizi rozhodně poznám (32", vzdálenost asi 3 metry). Zkoušel jsem i rozdíl mezi stejným BD na té HD Ready a Full HD a tam už žádný zřetelný rozdíl nevidím. Pro objektivitu by se ale slušelo upozornit, že ta Full HD Sony je nějak prapodivně nastavená, protože DVB-T vysílání na ní vypadá o poznání hůř než na mém Samsungu (rodiče si na něj ale bohužel nenechají sáhnout).

Na druhou stranu, zdaleka ne každý film vyšším rozlišením získá, takže u většiny filmů mi DVD bohatě stačí a BD by mi žádný "požitek" navíc nepřineslo. Ale kdyby si dnes pořizoval (nové díly) Star Wars, Matrix nebo LotR, určitě bych sáhl po BD.

Co se mne týká, rozdíl mezi DVD a BD na HD Ready (1366x768) televizi rozhodně poznám (32", vzdálenost asi 3 metry).Rozdíly poznat budou i když se bude zvětšovat rozlišení donekonečna. Teda aspoň dokud se nenarazí na nějaký limit. Jenomže kolik harmonických frekvencí obsahuje taková dokonalá hrana? U audia se alespoň toto hledisko začalo nějak zohledňovat v podobě SBR. U obrazu zatím nevím o ničem.

Zápisek dobrý až na ten závěr (přesně takový, jaký jsem od tebe čekal).

Protože ho nepoznají ani moji rodiče. A když si sednu v obyváku do křesla, tak mám co dělat abych ho poznal i já.

Jestliže máš křeslo tak daleko jak píšeš v jiném komentáři, je jasné, že nepoznáš rozdíl. Na PC monitoru ve vzdálenosti 45cm od tebe je rozdíl mezi 720x576 a 1920x1200 partný na první pohled. Zde jde o uhlové rozlišeni. Ale to ti snad vysvětlovat nemusím.

Jestliže máš křeslo tak daleko jak píšeš v jiném komentáři, je jasné, že nepoznáš rozdíl.Přesně tak, viz článek 1080p Does Matter, který jsem odkazoval níže.

Nedělejte to, obzvlášť s jakýmkoliv dalekohledem.Proč? Člověk dostane Fourierovu transformaci v reálném čase a nebude muset pálit procesorový čas. Jen s tou normalizací to asi bude trochu drhnout.

U všeho perecptuálního je hlavní chybou vnímat něco lineárně, protože nevím o jediném jevu, který by se v mozku vyhodnocoval lineárně.Vsak on take obraz v pocitaci jas neni kodovan linearne, ale je gamma komprimovan. Napr. na zmineny kontrast 1:1000000 bys potreboval 20 bitu v pripade linearniho kodovani, pri gamma=2 si vystacis s 10 bity.

V běžných fotografických objektivech se clonové číslo mění v řadě, ve kterém je každý nasledujíci člen je &sqrt; 2-násobně větší, než předchádzející, takže poměr světelného toku mezi dvěma sousedícími clonovými čísly je dvojnásobný, respektive poloviční (tj. odpovídá 1 EV – jednomu expozičnímu stupni).

1; 1,4; 2; 2,8; 4; 5,6; 8; 11; 16; 22 atd.

Oněch 33 EV je jako poměr 1:10 000 000 000 (jehož binární logaritmus je oněch 33 a něco) uvedeno v tomto článku o lidském oku.

Filmy se točí abyNení žádná univerzální pravda o tom, proč se točí filmy. Někomu může vyšší rozlišení umocnit emoce a lépe povědět příběh. Že to zrovna tobě tak nepřipadá, neznamená, že to platí pro všechny.

Este dodam ze vidiet napriklad Planet earth od BBC v HD na 24'+ (alebo HD televizore) je zazitok.

Oproti DVD neskutocny rozdiel.Nevím jak kdo, ale já na první pohled mezi kvantizovanou verzí a originálem nepoznám rozdíl.Bez urážky, tvoje pozorovací schopnosti budou asi dost nevalné.

A s nima vidím rozdíl cca z půl metru.

Ano, vysoké rozlišení má smysl dejme tomu u fotografií, ale ne u filmů.. Tam by měl panovat rozumný poměr mezi velikostí souboru a kvalitou. HD je v tomto směru zbytečný.

Pokud si budu chtít film užít ve velkém, tak si na něj zajdu do kina. Jenže já řeším spíš problém kam ty filmy uskladnit, aby se na ně jednou mohl podívat můj kluk.

Na film, který nikdo nezná nikdo do kina nepřijde. Na webu Jana Buriana najdete za jeho souhlasem se stahováním veškeré jeho produkce také velkým písmem napsanou větu: "KOPÍROVÁNÍ ZACHRAŇUJE HUDBU!"

Nejenom hudbu. A nesmyslné štvaní za HD vede k tomu, že si čím dál menší počet lidí bude schopno udržovat své sbírky. Zbytnělé HD snímky sežerou kapacitu jejich diskových prostorů jako malinu a vytěsní tak méně profláknuté věci do /dev/null.

Nakonec se pak naplní ten nejčernější scénář - že některé filmy nepůjde sehnat vůbec a jediná možnost jak se k nim dostat bude nechat si je promítnout za tučný peníz od NFA. Do doby, než jim sklady zruší zase nějaká živelná pohroma.

A s nima vidím rozdíl cca z půl metru.

Ano, vysoké rozlišení má smysl dejme tomu u fotografií, ale ne u filmů.. Tam by měl panovat rozumný poměr mezi velikostí souboru a kvalitou. HD je v tomto směru zbytečný.

Pokud si budu chtít film užít ve velkém, tak si na něj zajdu do kina. Jenže já řeším spíš problém kam ty filmy uskladnit, aby se na ně jednou mohl podívat můj kluk.

Na film, který nikdo nezná nikdo do kina nepřijde. Na webu Jana Buriana najdete za jeho souhlasem se stahováním veškeré jeho produkce také velkým písmem napsanou větu: "KOPÍROVÁNÍ ZACHRAŇUJE HUDBU!"

Nejenom hudbu. A nesmyslné štvaní za HD vede k tomu, že si čím dál menší počet lidí bude schopno udržovat své sbírky. Zbytnělé HD snímky sežerou kapacitu jejich diskových prostorů jako malinu a vytěsní tak méně profláknuté věci do /dev/null.

Nakonec se pak naplní ten nejčernější scénář - že některé filmy nepůjde sehnat vůbec a jediná možnost jak se k nim dostat bude nechat si je promítnout za tučný peníz od NFA. Do doby, než jim sklady zruší zase nějaká živelná pohroma.

kvalitusrovnávají subjektivně vlastními smysly (a hlavně se vsugerovanou myšlenkou

to stačíi když na ploše 1920x1080 budou čtyři obří bloky…

hlavně že to bude HD a ještě se ušetří). U menšího rozlišení na ten puk zbude aspoň jeden pixel. Někdy méně je prostě více. Také jeden z vedlejších důvodů, proč jsem se do něčeho podobného pustil a pokusil se to trochu sepsat.

Když si sundám brejle, tak to vypadá všechno stejně A s nima vidím rozdíl cca z půl metru.Tak asi potřebuješ upgrade brejlí. Moje brejle upgrade teda potřebují taky, ale asi ne tak drastický, páč rozdíl poznám i z větší vzdálenosti (na adekvátně velkým zobrazovadle).

Ano, vysoké rozlišení má smysl dejme tomu u fotografií, ale ne u filmů.. Tam by měl panovat rozumný poměr mezi velikostí souboru a kvalitou. HD je v tomto směru zbytečný.Ostatně soudím, že...

Na webu Jana Buriana najdete za jeho souhlasem se stahováním veškeré jeho produkce také velkým písmem napsanou větu: "KOPÍROVÁNÍ ZACHRAŇUJE HUDBU!"Znám, a souvislost z HD není.

A nesmyslné štvaní za HD vede k tomu, že si čím dál menší počet lidí bude schopno udržovat své sbírky. Zbytnělé HD snímky sežerou kapacitu jejich diskových prostorů jako malinu a vytěsní tak méně profláknuté věci do /dev/null.Nesmysl. HD dostupnost méně profláklých věcí nemění.

Nesmysl. HD dostupnost méně profláklých věcí nemění.Omyl. Hodně lidí, ne-li většina si film stáhne, zkoukne a dál neřeší, dokud jim nezačne docházet místo. Pak prostě smáznou to co už viděli. Pochopitelně s převahou HD je toho místa méně a méně. Jenže tak přežijí pouze nejprofláknutější věci, ale raritky, které zajímají jen úzkou skupinu lidí ne. A tím pádem se pak stávají nedostupné zcela. Abych byl konkrétní. Rád bych zkouknul jeden film. Třebas i v té nejmizernější kvalitě. Už jen pro to, abych věděl o čem je. Jenže jediné co jsem našel bylo remasterované DVD za nehorázných 12 litrů (v přepočtu na Kč). A takový fanda abych vypláznul takový peníz za zajíce v pytli zase nejsem.

Omyl. Hodně lidí, ne-li většina si film stáhne, zkoukne a dál neřeší, dokud jim nezačne docházet místo. Pak prostě smáznou to co už viděli. Pochopitelně s převahou HD je toho místa méně a méně.Nezapomněl na fakt, že velikosti disků se neustále rapidně zvětšují?

Jenže tak přežijí pouze nejprofláknutější věci, ale raritky, které zajímají jen úzkou skupinu lidí ne. A tím pádem se pak stávají nedostupné zcela.To ale platí i bez HD - je jasné, že když nějaký film zajímá jen úzkou skupinu lidí, tak ti ostatní ho na disku mít nebudou. To plyne už z definice okrajového filmu.

Abych byl konkrétní. Rád bych zkouknul jeden film. Třebas i v té nejmizernější kvalitě. Už jen pro to, abych věděl o čem je. Jenže jediné co jsem našel bylo remasterované DVD za nehorázných 12 litrů (v přepočtu na Kč). A takový fanda abych vypláznul takový peníz za zajíce v pytli zase nejsem.Jo, a to je určitě vina HD, žejo?

HD je pouze technologie, nic víc. Opruz je posedlost touto technologií.HD je rozlišení, nic víc, nic míň. Posedlost - to souhlasím - je opruz. Ne všichni příznivci HD jsou ale posedlí...

Velikosti disků se zvětšují? No nevím. Za poslední dva roky to zase takový skok není.Tak se mrkni třeba sem.

Pokud máš nasbíraný disk právě takových raritek, tak už si sakra rozmyslíš, jestli tomu disku nadále důvěřovat, nebo ne. Takže začneš disk zrcadlit.Lol, kolik máš na disku těch raritek ty? 100? 10? 5? 2? I kdyby to bylo těch 100, nemůžeme o nějakém problému s místem mluvit - film ve velmi slušný kvalitě v SD rozlišení může mít 4GB. 100 filmů má 400GB. Je to skutečně takový problém? A kolik místa doopravdy zabírají tvoje raritky?

Jenže nestíhají sběrnice. Takže i zálohování nebo i kontrola disku trvá nekonečně dlouho.Prosím? Kontrola a zálohování trvá nekonečně dlouho? Ty asi používáš starý IDE-33 rozhraní, prehistorický disk a ext2 nebo fat16 filesystém, žejo?

Blbě se odhalují chyby v takových souborech, protože výpočet kontrolního součtu je zdlouhavý.O čem to mluvíš? Jaký chyby? Ty máš v počítači virus, který ti náhodně přepisuje soubory na disku? Nebo o čem to mluvíš? Ty si běžně počítáš hashe filmů?

Komprese na snesitelnější velikost zase žere čas a výpočetní výkon (viz výše). Udělat kvalitní rip taky není jen tak, pokud chceš aby měl více audio stop, plus titulky. Kontrola titulků a případná oprava také žere čas. A to je ten lepší případ, kdy titulky existují.Ano, starat se o sbírku filmů, zvláště raritek, není triviální, ale (ne)existencí HD se na tom nic nemění...

Celé je to jenom o tom, že si tak jako autor tohoto blogpostu myslím že HD obsese je pouze výsledkem reklamní masáže a pro normální běžné čumily jako já postačuje to co dá DVD, zkomprimované nějakým rozumným kodekem.No jasně, názor typu "Ostatně soudím, že..."

HD je pouze technologie, nic víc.HD je technologie, asi tolik jako je technologie Adidas. HD je především značka.

Ty na té odlišnoti nic nevidíš?No jasně že jo. Vždyť je to komprimované a je to je také účel. Ukazuju to jen z toho důvodu, aby bylo vidět, že:

Nevím jak ty, ale já tam zřetelně poznávám obrys Leny.To je z toho důvodu, že vyšší frekvence obsahují především šum a hrany. Ale vadí to nějak?

toho není moc třeba ve srovnání s JPEGem o QP 50No to jistě ne. Ale to pořád neznamená, že je tento rozdíl nevýznamný.

I když to vypadá jako docela zásadní informace, tak kdo by si všiml, že tam vůbec toto chybí?Třeba já. Pokud by šlo o film, tak bych si toho určitě všiml.

To je z toho důvodu, že vyšší frekvence obsahují především šum a hrany. Ale vadí to nějak?Hrany jsou velmi důležité. Ty právě s kvatizací mizí, a tím se i obraz rozostřuje.

No to jistě ne. Ale to pořád neznamená, že je tento rozdíl nevýznamný.Tak se mi to začíná líbit.

No budiž. Až budu mít někdy čas, tak si pro tebe něco připravím.Třeba já. Pokud by šlo o film, tak bych si toho určitě všiml.

Tak schválně zkus na mě slepej test, uvidíš, že to poznám rychle bez nějakýho většího zkoumání. Ale prosil bych v tom případě stejnou míru kvantizace jako u výše ukázané Leny, ne, že to jen trochu pošolícháš, aby to nebylo poznat

Hrany jsou velmi důležité. Ty právě s kvatizací mizí, a tím se i obraz rozostřuje.Důležité? To určitě ano. Ale o jejich informačním významu docela pochybuju. Třeba u takového AAC, tam je ořez na

rozlišeníkolem 5000Hz(rozsah lidského sluchu je do 20kHz a i taková lama to řeže na 16kHz, občasně i více). Zbytek se zkopíruje, vhodně vyškáluje aby signál měl sestupný charakter a podle dat z doplňkového kanálu se ten zbytek dořeže aby se trochu víc podobal originálu. A když se nebude dostávat místo pro vedlejší kanál? Kdo by si toho všiml? Tóny zabarvené jsou, tak co. Docela zajímavý je nový spektrogram v ffplay. Určitě doporučuji zkusit. No co je to vlastně ta hrana? Nekonečné množství harmonických frekvencí. Sice nemám dostatečné znalosti aby řekl jak je to v obraze, ale tak nějak intuitivně cítím, že vývoj by se i v něm měl brát tímto směrem. Vždyť zkus někdy udělat ořez brick-wall filtrem a uvidíš sám.

Důležité? To určitě ano. Ale o jejich informačním významu docela pochybuju.No vidíš, to já zase ne

Třeba u takového AAC, tam je ořez na rozlišení kolem 5000Hz(rozsah lidského sluchu je do 20kHz a i taková lama to řeže na 16kHz, občasně i více). Zbytek se zkopíruje, vhodně vyškáluje aby signál měl sestupný charakter a podle dat z doplňkového kanálu se ten zbytek dořeže aby se trochu víc podobal originálu.Naprostá většina lidí neslyší nad 16kHz. Nicméně jsem ale názoru, že u zvuku je to trochu něco jinýho. Člověk zvuk a specielně hudbu vnímá jinak než obraz, alespoň jsem toho názoru... těžko říct, jesli existuje pralela s obrazem...

Dále je nutné brát na vědomí, že s narůstajícím rozlišením krom datové náročnosti roste hlavně náročnost výpočetní. Snad i rychleji než exponenciálně. A té alespoň na současné technologické úrovni není na rozdávání.Huh? A kde? Mnoho grafickych operaci ma casovou slozitost linearni k poctu pixelu (a tedy kvadratickou k rozliseni). Tedy ne ze bych nenasel takove algoritmy, ale nenapada me zadny, ktery by mel superpolynomialni slozitost a zaroven se pouzival v beznych aplikacich. Nehlede na to, ze vstupni data ve vysokem rozliseni muzes obvykle s linearni slozitosti snadno zredukovat na data s mensim rozlisenim a pak zpracovat.

Ovšem můj čistě osobní názor, který z toho vyvozuji je takový, že pouhé hnaní se za obřími rozlišeními je holý nesmysl. A to se týká jak značky HD (a následovníků jako je 4k,Super Hi-Vision) u videa, tak obřích Megapixelů u digitálních fotoaparátů. Hlavně protože lidský vizuální systém není takové rozlišení schopný dostatečně ocenit.Jenze vysoke rozliseni ma i jine duvody, nez se koukat na video ci fotku jako celek. Zejmena moznost zazoomovat si na detail. Napr. staticka kamera s vysokym rozlisenim (a dost sirokouhla) zaznamenava celou tabuli pri prednasce a uzivatel zaznamu pri prehravani posunem nahrazuje to, ze by mohl natacet hlavu (kdyby tam byl primo a nekoukal se na zaznam). Krom toho - rozliseni (ve smyslu DPI ci jeste lepe dots/radian) vlastne neroste. Dlouhodobe je kolem 100 pixelu na palec. Driv (za dob 14tipalcovych CRTcek a rozliseni 800x600) bylo sice trochu nizsi (kolem 70 pixelu na palec), ale ten narust za tech dvacet let je nepatrny. Rozliseni ve smyslu celkoveho poctu pixelu roste zejmena kvuli tomu, ze roste zobrazovana plocha. A lide na displeje koukaji vicmene ze stejne vzdalenosti, at jde o 14tipalcove CRT 800x600, nebo 24palcove LCD 1920x1080 (mozna spis ta pozorovaci vzdalenost klesa, protoze v dobach CRT byly obavy z vyzarovani z monitoru). Takze pokud na obou takovych pripadech uzivatel sleduje video v PAL rozliseni roztazene na fullscreen, tak na modernim monitoru se mnohem vic projevi nedostatky videa. (Proto take treba ja pri sledovani videa ho obvykle neroztahuju na fullscreen, ale necham v nativni velikosti.) Tedy - pro zachovani stejne urovne 'kvality' ('hustoty' informace vzhledem k pozorovacimu uhlu) je treba, aby rozliseni videa rostlo spolu s rustem 'rozliseni' (ne ve smyslu DPI) monitoru (a ne pomaleji).

Huh? A kde? Mnoho grafickych operaci ma casovou slozitost linearni k poctu pixelu (a tedy kvadratickou k rozliseni). Tedy ne ze bych nenasel takove algoritmy, ale nenapada me zadny, ktery by mel superpolynomialni slozitost a zaroven se pouzival v beznych aplikacich.Ono je to přesně naopak. Jednotlivé algorimtmy se optimalizují tak, že až člověk hledí kam se jim daří jejich komplexnost tlačit. Nad FFT (kterou se podařilo dostat na složitost N log N) a FFTW kroutím hlavou dodnes. To bude nejspíš nějaký druh magie. Jenomže je potřeba brát na vědomí, že časem jak se vyvíjí nové standardy, tak se do nich cpe stále více a více funkcí aby byly schopny více a více tlačit a stačily tak z dobou. Doporučuji porovnat třeba takový MPEG-1 a MPEG-4 AVC. Nárůst složitosti je neporovnatelně větší. A třeba o Vlnkové transformaci a Diracu nemluvím už vůbec. Ten bych o rozlišení 1080p na své počítači v reálném čase nepřehrál asi ani na obě jádra. Ona i ta Vlnková transformace vypadá velice jednoduše, ale když se provede jen tak bez pořádné matematické magie, tak se s verzí Ingridky vůbec nedá porovnávat. A ta se zase pro změnu stejně moc právě kvůli náročnosti nepoužívá.

Jenze vysoke rozliseni ma i jine duvody, nez se koukat na video ci fotku jako celek. Zejmena moznost zazoomovat si na detail.Další ultímátní otázka, kterou bych se chtěl zabývat až budu mít čas:

Je výřez ekvivalentní optickému zazoomování?. Zatím mám jen ničím nepodložené intuitivní podezření.

Krom toho - rozliseni (ve smyslu DPI ci jeste lepe dots/radian) vlastne neroste. Dlouhodobe je kolem 100 pixelu na palec. Driv (za dob 14tipalcovych CRTcek a rozliseni 800x600) bylo sice trochu nizsi (kolem 70 pixelu na palec), ale ten narust za tech dvacet let je nepatrny. Rozliseni ve smyslu celkoveho poctu pixelu roste zejmena kvuli tomu, ze roste zobrazovana plocha. A lide na displeje koukaji vicmene ze stejne vzdalenosti, at jde o 14tipalcove CRT 800x600, nebo 24palcove LCD 1920x1080 (mozna spis ta pozorovaci vzdalenost klesa, protoze v dobach CRT byly obavy z vyzarovani z monitoru). Takze pokud na obou takovych pripadech uzivatel sleduje video v PAL rozliseni roztazene na fullscreen, tak na modernim monitoru se mnohem vic projevi nedostatky videa. (Proto take treba ja pri sledovani videa ho obvykle neroztahuju na fullscreen, ale necham v nativni velikosti.) Tedy - pro zachovani stejne urovne 'kvality' ('hustoty' informace vzhledem k pozorovacimu uhlu) je treba, aby rozliseni videa rostlo spolu s rustem 'rozliseni' (ne ve smyslu DPI) monitoru (a ne pomaleji).K tomu už jsem se vyjadřoval. (druhý odstavec od konce)

jsou samé kecy. HD tu je, osobně ho také preferuji, protože je bezpochyby lepší. To že je autor asociální fašounek, který by povolil kvalitu jen pro ty, co ji rozeznají, je velmi smutné. No hlavně že ve svých dvaceti letech má ten jediný správný názor. Já ho měl taky, tak to chápu, ale zároveň mu doporučuji: najdi si babu, vole!vs

Zápisek jsem nečetlNevím co víc k tomu ještě dodat.

dostatečnéby mě nenapadlo snad ani po pořádném výzkumu. Ale na věcech, které jsem v zápisku napsal to vůbec nic nemění.

mplayer -vo png -frames 10 -sstep 1 -ss 530 Picture.This.1080p.x264.mkv

cp 00000002.png frame.png

ffmpeg -i frame.png -y -r 30 -an -vcodec libx264 -vpre libx264-hq -cqp 0 -s 854x480 o.mp4

mplayer -vo png -frames 1 o.mp4

mv -f 00000001.png frame-upscale.png

mogrify -scale 1920x1080 -filter Cubic frame-upscale.png

Ale já ten rozdíl vidím(Také by byla chyba kdyby ne) a víc čistý nezájem.

Všimněte si, že quantizer je nula, čili bezztrátová komprese...Opravdu umí x264 bezztrátovou kompresi? Není to jako s QP 100 u JPEGu? Pokud i ale ano, klidně stačilo použít třeba yuv4mpeg.

downscale na WVGA přes x264 + upscale zpátky na FullHDNo tak to teda nebyl moc dobrý příklad. Už jen protože tento obrázek toho v těch chybějících frekvencích má strašně moc. A jinak to šklálování je snad s Nearest-neighbor interpolací. Co třeba takhle?

Poznáte rozdíl? Za sebe hlasuju že ano.Zdá se, že ze zápisku si opravdu každý vezme to co chce. Psal jsem, že snížením rozlišení dochází k ořezu frekvencí. V nichž se krom šumu nachází také harmonické frekvence hran, které se v součtu podílí na výsledné ostrosti hrany. Viz třeba toto. Správný rekonstrukční filtr s ochranným pásmem ve tvaru Gaussovi křivky by měl také Gaussovo rozostření(dokonce existuje takový škálovací algoritmus třeba v libswscale). Gaussovo rozmazání doufám představovat nemusím. Ale vypadá to jako kdybych nic takového nikdy nenapsal.

408 - Request Timeout

Viz můj blogpost (jeden z mála) Lunetici na ABCLinuxu (aneb co si o nás Pinky myslí). S lidma jako Pinky opravdu nechci mít nic společného.

Viz můj blogpost (jeden z mála) Lunetici na ABCLinuxu (aneb co si o nás Pinky myslí). S lidma jako Pinky opravdu nechci mít nic společného.

Když zvětším rozlišení 2x, tak to znamená, že se mi počet bodů na palec zvětší 2x, což je 2x víc dat. Což je krásně lineární.Tak to asi neumím počítat nebo co, protože mně vychází minimálně parabola.

Mám takový silný dojem, že s tím exponenciálním růstem jsi to přehnal.Přehnal. A záměrně. Je nutné si uvědomit, že krom rozlišení rostla i bitová hloubka, způsob uložení, doplňkové věci a podobně. Pokud mám srovnat nějaký SCREEN$ a dnešní 16-bitové RAWy s profily…graf růstu obrazových dat by mě opravdu zajímal. Spíš mi šlo o to vyjádřit to, že objem rostl

rychle jak sviňaa ten výraz byl první nevulgární, který mě zrovna napadl a pokud to někomu vadí, tak se omlouvám.

i když jsme volily 16 barev

vy jste ženy?