Pro testování byl vydán 4. snapshot Ubuntu 26.04 LTS (Resolute Raccoon).

Ben Sturmfels oznámil vydání MediaGoblinu 0.15.0. Přehled novinek v poznámkách k vydání. MediaGoblin (Wikipedie) je svobodná multimediální publikační platforma a decentralizovaná alternativa ke službám jako Flickr, YouTube, SoundCloud atd. Ukázka například na LibrePlanet.

TerminalPhone (png) je skript v Bashi pro push-to-talk hlasovou a textovou komunikaci přes Tor využívající .onion adresy.

Před dvěma lety zavedli operátoři ochranu proti podvrženým hovorům, kdy volající falšuje čísla anebo se vydává za někoho jiného. Nyní v roce 2026 blokují operátoři díky nasazeným technologiím v průměru 3 miliony pokusů o podvodný hovor měsíčně (tzn., že k propojení na zákazníka vůbec nedojde). Ochrana před tzv. spoofingem je pro zákazníky a zákaznice všech tří operátorů zdarma, ať už jde o mobilní čísla nebo pevné linky.

Společnost Meta (Facebook) předává React, React Native a související projekty jako JSX nadaci React Foundation patřící pod Linux Foundation. Zakládajícími členy React Foundation jsou Amazon, Callstack, Expo, Huawei, Meta, Microsoft, Software Mansion a Vercel.

Samsung na akci Galaxy Unpacked February 2026 (YouTube) představil své nové telefony Galaxy S26, S26+ a S26 Ultra a sluchátka Galaxy Buds4 a Buds4 Pro. Telefon Galaxy S26 Ultra má nový typ displeje (Privacy Display) chránící obsah na obrazovce před zvědavými pohledy (YouTube).

Byla vydána grafická knihovna Mesa 26.0.1 s podporou API OpenGL 4.6 a Vulkan 1.4. Je to první stabilní verze po 26.0.0, kde se novinky týkají mj. výkonu ray tracingu na GPU AMD a HoneyKrisp, implementace API Vulkan pro macOS.

Byla vydána nová verze 4.6 multiplatformního integrovaného vývojového prostředí (IDE) pro rychlý vývoj aplikaci (RAD) ve Free Pascalu Lazarus (Wikipedie). Využíván je Free Pascal Compiler (FPC) 3.2.2.

Byla vydána nová verze 3.23.0 FreeRDP, tj. svobodné implementace protokolu RDP (Remote Desktop Protocol). Opravuje 11 bezpečnostních chyb.

Španělský softwarový inženýr oznámil, že se mu podařilo na dálku ovládat sedm tisíc robotických vysavačů po celém světě. Upozornil tak na slabé kybernetické zabezpečení těchto technologií a jejich možné a snadné zneužití. Nesnažil se hacknout všechny robotické vysavače po světě, ale pouze propojil svůj nový DJI Romo vysavač se zařízením Playstation. Aplikace podle něj ihned začala komunikovat se všemi sedmi tisíci spotřebiči a on je

… více »... oproti klasickému rozdělení disku? LVM přináší jednotný systém správy diskových oddílů a odděluje tak oddíly se souborovými systémy a daty od fyzických disků. LVM umožňuje:

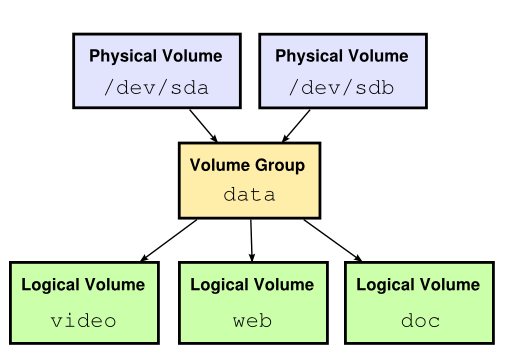

Koncept LVM lze rozdělit do tří vrstev. Fyzický oddíl (Physical Volume - PV) je místo na blokovém zařízení (typicky pevný disk, oddíl či celé diskové pole). Aby šlo využít místo na disku (nebo třeba jen diskovém oddílu) pro LVM, je potřeba na tomto disku/oddílu (obecně blokovém zařízení) vytvořit PV.

Druhou vrstvou je skupina oddílů (Volume Group - VG). VG v sobě zahrnuje datový prostor ze všech fyzických oddílů do této skupiny přiřazených a toto místo distribuuje do jednotlivých logických oddílů (Logical Volume - LV).

LV tvoří poslední vrstvu konceptu LVM. Na LV už lze vytvořit systém souborů nebo jej používat jako kterékoliv jiné blokové zařízení. Vše je patrné ze schematu:

LVM vlastně spojí místo z pevných disků či jiných úložných zařízení (PV) do jednoho celku (VG) a poté jej opět rozdělí podle potřeby na jednotlivé oddíly (LV).

Pro použití pevného disku v LVM je nutné nejdříve vytvořit PV (physical volume - fyzický oddíl).

pvcreate /dev/sda

PV je možno vytvářet buď na celém disku (např. /dev/sda), nebo na oddílu (např. /dev/sda1 s typem 0x8e). Při vytváření PV na celém disku mohou ostatní operační systémy disk identifikovat jako prázdný a pokusit se vytvořit korektní tabulku oddílů (partition table), čímž poškodí PV a hrozí ztráta dat. Pokud se bude disk používat pouze v jednom OS, nepředstavuje tento způsob vytvoření problém. Obecně je však vhodnější vytvořit PV na oddílu. Pro ostatní OS to bude v nejhorším případě neznámý diskový oddíl (nebo systém souborů), na který ale nebudou zapisovat.

Příkazem pvdisplay můžeme získat informace o fyzickém oddílu. Bez parametru vypíše informace o všech PV v systému (což je často užitečné, ne každý PV musí být zahrnut do skupiny, a je tak snadné na něj zapomenout), nebo lze výpis omezit pouze na jeden oddíl:

pvdisplay /dev/sda --- Physical volume --- PV Name /dev/sda VG Name data PV Size 8.00 GB / not usable 4.00 MB Allocatable yes PE Size (KByte) 4096 Total PE 2047 Free PE 2047 Allocated PE 0 PV UUID lvii22-MKBz-g4nO-zZO2-CsxP-SBmH-Ndij9W

vgcreate data /dev/sda

Příkaz vgcreate jako první povinný parametr očekává jméno skupiny, za kterým následuje seznam diskových oddílů (zinicializování pomocí pvcreate), které chceme zahrnout do vytvářené skupiny.

Pro zobrazení informací o skupině slouží příkaz vgdisplay. Bez parametru vypíše informace o všech logických skupinách v systému, s parametrem jména skupiny vypíše informace o té požadované skupině.

vgdisplay data --- Volume group --- VG Name data System ID Format lvm2 Metadata Areas 1 Metadata Sequence No 1 VG Access read/write VG Status resizable MAX LV 0 Cur LV 0 Open LV 0 Max PV 0 Cur PV 1 Act PV 1 VG Size 8.00 GB PE Size 4.00 MB Total PE 2047 Alloc PE / Size 0 / 0 Free PE / Size 2047 / 8.00 GB VG UUID 5N1yvF-YMBO-301k-zBIg-ssY1-sLCC-kV8GwA

Výpis zobrazuje, kolik je dané skupině přiřazeno fyzických oddílů, počet vytvořených logických oddílů, volné místo a další údaje. Skupina "data" je zatím prázdná.

Logický oddíl již představuje místo, na kterém lze vytvořit systém souborů a ten následně připojit nebo jej používat jinak jako běžné blokové zařízení. Je tak obdobou klasického oddílu.

lvcreate --name video --size 2G data

Minimální parametry příkazu lvcreate jsou:

--name, v příkladu "video"),--size),Po této akci zpravidla následuje vytvoření systému souborů a připojení pro běžné používání.

mkfs.ext3 /dev/data/video mount /dev/data/video /mnt

Cesta k LV se může lišit podle nastavení udev. Obvykle vytváří link /dev/skupina/oddil nebo /dev/mapper/skupina-oddil

Před samotných zrušením je třeba odpojit systém souborů.

umount /mnt lvremove /dev/jmeno_skupiny/jmeno_oddilu

Příkaz lvremove se dotáže na potvrzení zrušení a poté oddíl zruší a zvětší se tak volné místo v dané skupině oddílů.

V dalším dílu se naučíme přidávat (a také odebírat) další disky do skupiny a zvětšovat tak volné místo pro oddíly. Dále budeme zvětšovat i zmenšovat stávající oddíly i systém souborů.

Nástroje: Tisk bez diskuse

Tiskni

Sdílej:

![]()

![]()

![]()

![]()

![]()

![]()

neresi to pak nahodou -C u lvcreate?

nebo by se obnove lvm/dat, mohl venovat nektery z dalsich dilu serialu.

Jo, plánuji to zařadit do některého z pozdějších dílů.

neresi to pak nahodou -C u lvcreate

no mel by, ikdyz si tim nejsem uplne jistej.....by to mohl nekdo ve virtualu nebo na souborech vyzkousek ;)No, ten prepinac -C neni tak moc reseni. Jenom proste pomoci -C se da rict, ze se ma LV udelat souvisle na jednom PV (kde je misto), pripadne, jak se urci pri pvcreate na cmdline (posledni parametr). Kdyz pak chybi disk, tak (pokud si to jeste pamatuju) se pouzije pri vgchange parametr --partial (ikdyz moje man stranka ten parametr nepopisuje, jenom ho uvadi ve syntaxi). Problem je, kdyz neni dostatek mista na zadnej PV, tak proste takovou LV nevytvoris a taky bude contiguous LV asi o trosku pomalejsi, nez LV distribuovana na ruzny PV. Rozhodne je spis lepsi mit v zaloze nejakej jinej system na obnovu VG, pripadne na vytazeni aspon nejakych dat, ale je fakt, ze kdyz proste zmizi celej disk, tak se z toho nic kloudnyho nedostane. Spis kdyz se LVM nejak rozhasi, jako napr. FS bez zurnalu pri padu systemu.

Dovolim si nesuhlasit. U nas to robime celkom bezne a bezpecne. Pripajame vzdialeny storage (SAN) a len vdaka LVM vieme jednoducho, rychlo a bezbolestne uspokojit meniace sa poziadavky zakaznikov. Ak potrebuju vacsiu kapacitu jednoducho na filery vyexportujeme nove zariadenie a pridame do volume groupy. Nesledoval som vyvoj LVM od zaciatku ale predpokladam, ze bolo navrhovane najma pre taketo pripady.

protoze pravdepodobne nealokujete jednotlive fyzicke disky, ale volumy vytvorene na nejakem RAIDu,rozhodne PV na partisnach bych delal jenom pro velky mnozstvi nedulezitych dat (ala RAID0) - spojeni vice disku do jednoho vetsiho (klidne i RAID0 a nad tim jednim diskem LVM). Netusim ted, jestli do RAID0 jdou pridavat dalsi disky tak jednoduse jako do LVM, ale vytvoreni VG je neco na zpusob RAID0, s tim, ze z VG muzu disk zase odebrat. Na dulezity veci samorezjme nejdriv z disku udelat nejaky bezpecny RAID a na tim pak teprve tvorit PV/VG/PV.

na linuxu se da pouzit SW RAID jako pojistka proti ztrate dat pri vypadku fyzickeho disku.

Opatření proti ztrátě dat je záloha. Mirror pouze pomůže ve chvíli, kdy spadne disk (stačí přidat nový a jede se dál), ale určitě bych nezatracoval více disků ve VG jen proto, že data nejsou chráněna. Nejsou, protože to se řeší jejich zálohou a nikoliv správou diskových oddílů.

A co kdyz je od posledni zalohy z disku jenom cteno?

Já nevim. Protože pak by to byl RAID?

(:

o lvm nic moc nevim - presto; to co pisete, zni logicky a jako jasna vyhoda toho, proc vubec zavadet nejakou dalsi vrstvu, preci jinak (nebylo by li vhodne davat vice fyzickych disku do volume group) by to nic moc neprinaselo

/home na LVM stripe setu (taktéž se o tom zmíním, asi ve třetím dílu), a nebojím se o data, protože každou noc se to stejně zálohuje - jak píšu výše, stejně by se to zálohovalo i kdyby to bylo na mirroru.

mam 5 disku ve volume group, lze udelat "chci vyndat tento 1 disk, misto na zbylych 4 staci, aby se tam vsechna data vesla, premigruj a uvolni" ?

jinak teda to zni nedobre, jestli odchod jednoho disku znamena necitelnost cele vg, daleko prijemnejsi by bylo, kdyby bylo zajisteno, ze proste holt nebudou viditelna data z necitelneho disku (tozn. 1 soubor by vzdy musel byt cely na nejakem 1 konkretnim disku; asi dusledek oddeleni konkretniho fs od lvm, ktery dovnitr nevidi)

mam 5 disku ve volume group, lze udelat "chci vyndat tento 1 disk, misto na zbylych 4 staci, aby se tam vsechna data vesla, premigruj a uvolni" ?

Ano jde, nastuduj si příkaz pvmove (nebo si počkej na další díl). pvmove přesune data buď tam kam mu určíš, nebo bez určení kam to přesune na volné místo na ostatních PV.

proste holt nebudou viditelna data z necitelneho disku (tozn. 1 soubor by vzdy musel byt cely na nejakem 1 konkretnim disku

Toto LVM zajišťovat ani nemůže. Na toto jsou systémy souborů typu ZFS a BTRFS, které spojují manager oddílů a systém souborů do jednoho.

diky za info, problem manualovych stranek je, ze popisuji ideal, ale nehovori i realite

mate tez nejake zkusenosti s realnym (nejlepe osobni a ve firme popr. velke firme) provozem? ja se s linuxem prilis moznosti setkat nemel, z for pak citam informace od "proc cokoli jineho, kdyz lvm+ ..." po dnesni prvni "nedoporucuje se vic disku do volume group"

mate tez nejake zkusenosti s realnym (nejlepe osobni a ve firme popr. velke firme) provozem?

Jistě (nepouštěl bych se do psaní o něčem, co sám nepoužívám a čemu nevěřím), LVM doma provozuji již několik let k plné spokojenosti (momentálně 4TB místa). Na firmě používáme na správu diskových polí (po 12TB) software OpenFiler, který též používá LVM a nabízí exporty přes NFS, sambu a iSCSI, atd. LVM rozhodně není žádná unstable novinka, ale dospělý produkt, který se docela běžně používá.

Pokud se ptas na zkusenosti s pvmove, tak ja jsem s tim spokojen. Pouzil jsem jej sice pouze na pracovnim notebooku, ale nekolikrat jsem delal kompletni restrukturalizaci disku tak, ze jsem do VG pripojil externi USB disk (pripadne pres loopback soubor vytvoreny na tomto disku), presunul vsechny LV, puvodni disk odpojil z VG a nasledne vymenil nebo prepartisnoval a pote zpatky. Kdyz jsem dostal novy notebook, tak jsem puvodne chtel za behu pri praci data presunout z jednoho disku na novy, ale nakonec jsem migroval 32bit -> 64 bit, takze jsem to nevyuzil.

Jinak u pvmove neni problem killnout dany proces (presun bezi dal) nebo restartovat system.

Nicmene i pres spolehlivost popsane cesty durazne doporucuji provest zalohu dulezitych dat. I ja jsem ji provedl, i kdyz devmapperu a lvm verim. V techto a podobnych operacich je vzdy potencialni riziko.

Michal

(a s tím ani super nezhoditelné pole nic neuděláSuper nezhoditelné pole se samo mirroruje na více lokací a na každé této lokaci si i samo vytváří snapshoty pro účely ochrany před tupými uživateli.

Prostě máš například v adresáři .snapshots zálohy z určitých dní/hodin/minut

Prostě máš například v adresáři .snapshots zálohy z určitých dní/hodin/minut

Já také netvrdil, že jsi to řekl.

Prostě máš například v adresáři .snapshots zálohy z určitých dní/hodin/minut

Takže v podstatě to, co mi dělá rsnapshot každou noc, akorát na jiné úrovni. Hodit se to může. Jenže, stále to není záloha. Je to takový koš, by se dalo říct.

Jen pro doplnění - http://www.avc-cvut.cz/avc.php?id=4714

Jinak já osobně čekám spíše na btrfs

+1

Jak je to s bezpečností ukládaných dat? V jakém "formátu" jsou na disku fyzicky? Když se např. v polovině operace vypne proud a mám FS se žurnálem, který to nějak rozchodí, rozchodí to stejně i LVM když v LV bude ten samý FS, nebo ta mezivrstva mezi diskem může způsobit problém?

Ha, na tu fragmentaci bych se chtěl zeptat, páč vůbec nevim co se s tím děje, když například na jednom disku je jedna pv, pod tím jedna vg a pod tím několik lv (volné místo využité do mrtě) a zmenším jeden oddíl a druhý zase zvětším a za týden zmenším ten druhý a zvětším zase třetí. Fragmentuje se to nějak či má lvm nějaký účinný mechanyzmy aby tomu zabránila?

Pokusím se to vysvětlit na příkladu, snad se ty zkratky nepopletou. Každý PV má určitý počet bloků, což je nejmenší alokační jednotka jejíž velikost se dá nastavit. V terminologii LVM je to physical extents - PE. Každý PV tedy má určitý počet PE a skupina (VG) má pak k disposici místo (tedy alokační jednotky PE) ze všech fyzických oddílů (PV). Uff. Příklad, disk o velikosti 100PE a tři oddíly:

Máme obsazený celý disk třemi oddíly s uvedenými PE, kde se nacházejí:

Oddíl A se nachází na PE 1 až 25

Oddíl B na PE 26-50

Oddíl C na PE 51-100

Teď A a C zmenším, situace může vypadat takto:

Oddíl A na PE 1-15

Oddíl B na PE 26-50

Oddíl C na 51-80.

Mám tedy k disposici 30PE místa a vytvořím oddíl D, ten bude na PE rozsahu 16-25 a na rozsahu 81-100. Rozložení na VG pak bude vypadat takto:

A na 1-15

D na 16-25

B na 26-50

C na 51-80

D na 81-100

Počet segmentů (i přesné rozsahy PE) lze získat, například příkazem lvdisplay:

LV Name /dev/data/dvd VG Name data LV UUID aKAew6-W2ah-kng3-QRN4-ziAN-hL1f-Ncuu1U LV Write Access read/write LV Status available # open 1 LV Size 183.00 GB Current LE 46848 Segments 3 Allocation inherit Read ahead sectors auto - currently set to 256 Block device 253:1

Takže ano. fragmentuje se to a LVM toto samo o sobě neřeší - samozřejmně se snaží LV umístit do souvislé oblasti, ale ne vždy to jde. Ale LV o více segmentech se nijak automaticky nedefragmentuje (např. po přidání dalšího PV do VG). Jde ale to popřesouvat ručně programem pvmove, ale je to zbytečné - těch segmentů je velmi málo a jsou velké.

Uf, díky za vyčerpávající odpověď. Nějak sem to i tušil, i když díky za tu radu s těma segmentama. Ten příklad tak nějak odpovídá tomu co mám doma na desktopu, a v poslední době jaksi začlo docházet místo na více oddílech, takže sem takovéhle harakiri už několikrát prováděl abych to trochu přeuspořádal a uvolnil místo na kritických oddílech. No nejvyšší čas přikoupit nějakou tu kapacitu navíc. :)

Předcházet (vlastně jen zakázat) fragmentaci lze pomocí správného výběru alokační strategie. Popsáno to je v lvm(8) u parametru --alloc.

Bylo by dobré ve článku vysvětlit, nejen jak se s LVM pracuje, ale také jak LVM funguje.

To jest vztah mezi device mapperem a nástroji LVM, formáty metadat (a jejich verze), kam se ukládá konfigurace svazků a kam konfigurace LVM, jak se při startu systému LVM svazky hledají, jak se svazky zastavují atd.

Tohle všechno pomůže LVM oddémonizovat, umožní pochopit principy, na kterých funguje, a v důsledku poskytne správci tolik nutný nadhled a porozumění, aby se LVM nebál a uměl řešit neobvyklé situace (kdy se přehazují disky mezi stroji, když jeden disk umře, když se udělá snímek souborového systému, který se připojuje podle UUID).

+1 Taky LVM používám zatím k plné spokojenosti ve firmě, ale furt mě hryže ta nejistota "kdyby se ti náhodou podařilo tomu nějak ublížit, tak jsi v pr*****". Něco ve smyslu partition table a MBR - pitomejch 512 bajtů, ale když o ně přijdeš, přijdeš o všechno... O.

Vzdy jsem myslel, ze LVM ma kazdy, kdo sifruje.

Pouzivam vic disku, nad kterymi nastavim RAID. Zakladam malicky svazek pro /boot a na zbytku vytvorim sifrovany svazek, ve kterem pomoci LVM rozsekam system dle potreby. Neumim si to bez LVM predstavit. Musel bych zadavat 20+ heslo pro kazdy svazek zvlast, nebo se to da udelat elegantneji?

Tak takovéhle články jsou velkou vzácností. Jinak je to samý rozhovor, reklama, nové verze, odlehčená témata, shrnutí, tiskové zprávy, zpravodaje, recenze, události, komentáře, hlasování, soutěže atd. Schválně jsem koukal, kdy se tu naposled objevil aspoň trochu hardcore článek. A hle - 11. 12. 2008 článek o ACL dokonce od stejného autora, čímž ho velmi oceňuji. Těším se na další díly.

Jak to neobsahuje kusy zdojáků ani ukázky výpisů z terminálu, tak je to vata. Ještě uznávám jaderné noviny.

...budu se snažit najít další hardcore témata.

Hlavně ne ta, která někdy v souvislosti s tebou zmiňuje Pinky. ^_^

Jinak fajn článek, těším se na pokračování.

K tomu zrcadlení - z hlediska funkčnosti, stability a možnosti zotavení z chyb, je jedno, jestli na serveru použiju zrcadlení v LVM nebo softwarový RAID 1? Co používáte vy?  (Já Linux Software RAID.)

(Já Linux Software RAID.)

Tak jsem si pročetl LVM HOWTO a jeden docela zajímavý materiál od RedHatu. Nějak z toho mirrorování v LVM nemám dobrý pocit; za prvé, zdá se, že mnoho lidí používá LVM nad RAIDem (a asi to nedělají jen ti, co o této featuře LVM nevědí); za druhé, LVM si potřebuje vést nějaký log, který je buď v paměti a po rebootu je nutné pole resychronizovat (jak dlouho to trvá?), nebo může být na disku (a prý drobně snižovat výkon). To se mi nějak nezdá, Linux Software RAID nic takového nemá

po rebootu je nutné pole resychronizovat (jak dlouho to trvá?)

Dlouho. Přesný čas neřeknu, ale když jsem s tím experimentoval, tak ta synchronizace byla z mého pohledu bylo nepoužitelně dlouhá. je to škoda, protože jinde (HP-UX) mirror v LVM používám zcela bez problémů.

Dobrej, clanek. Doufam, ze dalsi dily budou nasledovat co nevidet. Jsem pomerne obeznamen s volume managerem na solarisu, ale LVM na linuxu mi trochu unikalo. Resp. pokud jsem neco delal s LVM, tak pres nejake gui. Konecne srozumitelny serial jak to resit pres cli.

On už tu jeden stručný článek byl, ale předpokládám, že Heron to chce vzít trochu podrobněji

Mna by skor zaujimalo, ako je to s pridavanim diskov do raid 5. S raidom mam osobne skusenosti len v mirror-e, 5-ku som zatial v rukach nemal. Preto by som sa chcel opytat, ci je mozne do existujuceho raid-5 postupne pridavat dalsie disky pre zvysenie kapacity pola, alebo nie. Osobne to zatial robim tak, ze mam lvm nad raid-1 a v pripade potreby dalsej volnej kapacity vytvorim dalsi raid-1 a to lvm rozsirim aj na neho ( takze mam lvm nad 2xraid-1 ).

mdadm --add /dev/md0 /dev/disk a poté reshape toho pole mdadm --grow /dev/md0 --raid-devices 5. Více na mém webu.

Mno, zajímavý. A to jako kernel hned ten device /dev/md0 vidí jako zvětšený? Když je to SW RAID, tak asi ano - takže není důvod k rebootu. To je super.

Já používám ve firmě HW RAID-5 alá Dell MD-3000 a tuhle jsem ho potřeboval taky zvětšit. Narval jsem tam disk, přepočítal pole, ale ouha, Linux (RHEL-5) viděl zařízení /dev/sde v pořád stejné velikosti. Takže jsem musel rebootovat a až teprve pak pvresize. Toto už by prý mělo být možno udělat v nejnovějších kernelech bez rebootu (tj. detekce změny velikosti kapacity připojeného SCSI zařízení za běhu).

echo "- - -" > /sys/class/scsi_host/host0/scanZdar Max

Zajimavy clanek. LVM doma pouzivam na filmy a jsem s nim spokojen az na jednu vec, ktera me docela stve a to je rychlost. Chtel bych se optat, jestli by mi nekdo neporadil, jak to urychlit. Byl bych za to docela vdecny. Slysel jsem, ze pri pouziti disku vetsi nez 2T by mel byt opatchovany kernel, aby LVM fungovalo nejak rozumne.

Kdyz jsem instaloval OS, tak jsem udelal tu hloupost, ze jsem na cely /home/ dal LVM. Ze zacatku se PC choval dobre, system slapal rychle. Pak jsem dokoupil par disku, nafoukl LVM a ted je to v takovem stadiu, ze po prihlasni do KDE musim cekat tak 5-10min nez mam moznost neco delat. Je to opravdu strasne. Na LVM mam z 90% bluray filmy, z 8% mp3 a zbytek jsou nejake dokumenty a weby. Napadlo me koupit disk a udelat z nej ciste jen /home/ a filmy nechat samostatne na LVM, ktere bych jen mountoval.

Budu rad, za kazdou radu.

Rozdeleni disku:

/dev/root 4,7G 263M 4,5G 6% /

/dev/sdb6 9,4G 5,7G 3,7G 61% /var

/dev/sdb7 9,4G 1,3G 8,1G 14% /opt

/dev/sdb9 37G 19G 19G 50% /usr

/dev/sdb8 2,0G 33M 1,9G 2% /tmp

/dev/mapper/vg-home 3,2T 3,0T 286G 92% /home

/dev/sda5 215G 64G 151G 30% /mnt/widle/data

LVM:

VG Name vg

System ID

Format lvm2

Metadata Areas 7

Metadata Sequence No 18

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 1

Max PV 0

Cur PV 4

Act PV 4

VG Size 3,18 TB

PE Size 4,00 MB

Total PE 834632

Alloc PE / Size 834632 / 3,18 TB

Free PE / Size 0 / 0

VG UUID hbLrpo-Gyr2-iJyR-Peiw-Xs9t-bd4u-lr3Eqe

/dev/vg00/lv_usr alebo /dev/vg_data/lv_sql popripade /dev/mapper/vg00-lv_home tak mu musi byt jasne o co ide.